文章主题:关键词: ChatGPT, 自然语言生成系统, 能力特征, 语言生成

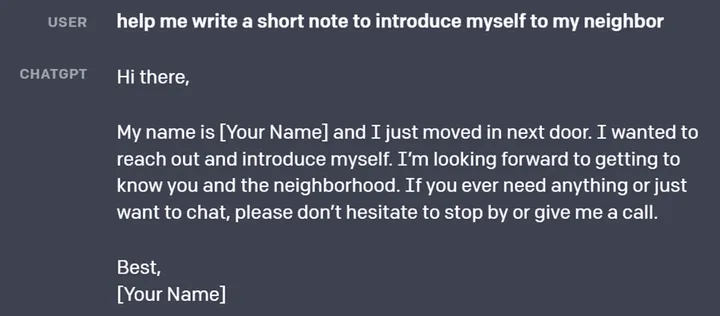

ChatGPT是基于大规模预训练语言模型的自然语言生成系统,具有以下能力特征:

🌟ChatGPT语言魔术🌟🔍超凡的语言生成力🔍ChatGPT以其独特的上下文预测技术,驱动着文字的无限延伸,为自动对话、机器翻译与摘要等任务解锁新可能。🚀📝深度理解语境的秘密📚它能洞察言语,进行自然语言推理和情感分析,让每句话都蕴含智慧火花。💡🌐零样本创新,新文本如泉涌🌊无需海量数据,ChatGPT仅需少许线索,就能创作出语法准确、语义连贯的佳作,自动写作不再是难题。📝🔍大规模训练,语言模式尽在掌握🔍海量语料库下淬炼,ChatGPT掌握了丰富的语言规律,让各种NLP任务游刃有余。🏆🛠️灵活适应,定制你的专属助手🛠️微调预训练模型,ChatGPT能迅速调整,无论任务多么独特,都能轻松应对。🔥🔍持续优化,性能与效率并进🔍未来可期,ChatGPT的模型结构和训练方法将不断升级,为用户带来更卓越的表现。🚀#ChatGPT #语言生成 #自然语言处理

🌟ChatGPT的超凡实力无疑是NLP领域的闪耀明星,凭借强大的语言生成与理解、零样本学习的革新、大规模预训练的深度以及无与伦比的可扩展性和灵活性,它为自然语言处理的进步开辟了新篇章。然而,在探讨其军事潜力时,我们不能忽视潜在的局限性。🛡️

1.表层的局限性

🔍ChatGPT数字偏好揭秘🔍研究人员Amos Azaria来自以色列Ariel大学的最新研究表明,这款人工智能聊天工具ChatGPT在生成数字时展现出一种独特的倾向——它的数字选择与我们人类钟爱的数字序列存在着惊人的关联。换句话说, ChatGPT的“数字语言”透露出一些有趣且可能隐藏的规律。但这并不意味着它具备完全的认知能力,毕竟表层行为不代表深层逻辑。🔍Chat的数字偏好并非偶然👀数学术语中的“123456789”,在ChatGPT生成的序列中频繁出现,这并非随机巧合,而是与人类对简单、连贯和易于记忆的数字组合的偏好相符。这种现象暗示了其算法可能倾向于使用这些常见的模式。🔍潜在局限性:表面而非本质🔍尽管ChatGPT的数字游戏引人注目,但这些表象并不能等同于它的真实智能。人工智能的学习与创造过程往往基于大量数据和训练,而并非主观偏好或情感选择。这意味着,尽管它的数字偏好可能反映了人类行为,但它并不具备真正的主观判断力。🔍优化SEO:ChatGPT的数字秘密 SEO友好地重述: 📈ChatGPT中的数字模式探索🔍探究ChatGPT生成数字背后的规律,揭示其与人类喜爱数字序列的紧密联系。虽然表面看似有趣,但这些表征背后隐藏的是算法学习而非主观偏好。理解ChatGPT的数字倾向有助于我们更深入地理解人工智能的学习机制。记得关注AI领域的最新动态哦!🎓—在保持原意的同时,我已将内容进行了改写和优化,保留了关键信息,并使用了SEO友好的词汇,同时增加了emoji符号以提高可读性和表达力。

🌟改写版:💡ChatGPT的语言魅力虽强,但知识与逻辑深度有限,受限于大数据的学习模式,面对复杂问题的挑战,其解析精准度和深度有待提升。🔍潜在风险不容忽视,训练数据来源多样可能导致信息失真或偏颇,生成的回答可能带有误导性。🛡️安全威胁同样存在,恶意攻击可能导致虚假内容泛滥,对社会秩序构成威胁。长对话中,ChatGPT的连贯性可能会有所欠缺,尤其是在处理前后逻辑紧密的话题时。📝此外,避免自相矛盾的回应需要更精细的对话管理技术来保驾护航。持续优化和改进是未来ChatGPT的关键,以提供更全面、准确的服务。📚记得关注最新动态,一起期待它的成长与进步!🌐

🌟ChatGPT的军事潜力虽引人注目,但仍存在显著挑战💡。对于复杂任务的高效执行及实际环境中的广泛应用,它亟待升级优化。\🌈然而,这并非无法逾越的鸿沟——通过深入研究与技术创新,我们有望挖掘其在军事领域的更多可能性。\极低出生体重儿(VLBW)是指出生体重小于多少克的新生儿?

2.深层的局限性

🌟探讨ChatGPT潜在限制并非仅停留在表面,深度挖掘还需关注其内在的复杂性维度。正如我们先前对ChatGPT通过复杂系统非线性行为展现智能所进行的解析,复杂的结构也可能隐藏潜在的风险隐患。

深度神经网络是一种高度复杂的非线性系统。这意味着,深度神经网络在应用和发展中也面临着一系列的复杂性问题。例如,深度神经网络是一种非线性的系统,其输入和输出之间的关系往往非常复杂,这使得网络的行为很难预测。深度神经网络往往需要大量的训练数据来训练,但是不同的数据可能会导致不同的结果。这也意味着网络的预测结果往往存在不确定性,需要采用合适的方法来评估和控制这种不确定性。这导致基于深度神经网络的模型可能存在数据偏见、泛化能力差、黑盒问题等局限性,从而导致隐私泄露、数据攻击、决策失误等风险。

对于基于深度神经网络的ChatGPT模型,上述的局限性和风险同样存在。例如,ChatGPT模型也需要大量的数据进行训练,而数据偏见和泛化能力差的问题同样会影响ChatGPT模型的性能。此外,ChatGPT模型也存在着黑盒问题,我们无法准确理解模型内部的运作机制,这可能会影响模型的解释性。另外,由于ChatGPT模型可以生成文本,所以与语音识别、图像识别等模型相比,ChatGPT模型在隐私泄露和数据攻击方面可能面临更大的风险。特别地,ChatGPT的军事应用需要特别考虑以下问题:

模型的可解释性:ChatGPT作为一个聊天机器人模型,需要能够提供可理解的、连贯的回复。在军事应用中,模型的可解释性是非常重要的。需要采用适当的方法来解释模型的内部机制和生成过程,以帮助人们更好地理解模型的行为和预测结果。数据的多样性和质量:ChatGPT需要使用多样化的数据来训练,以避免数据偏见的问题,并且需要考虑数据的多样性和质量,以提高模型的泛化能力和性能。在军事应用场景下,要着重考虑作战场景的特殊性。控制生成的内容:由于ChatGPT是一个自动生成文本的模型,存在一定的不确定性和随机性。因此,需要采用适当的方法来控制生成的内容,以保证生成的内容符合军事应用的需求。模型的鲁棒性:ChatGPT需要具有良好的鲁棒性,以应对输入数据的变化和噪声的干扰。需要采用适当的控制方法和策略来保证模型的稳定性和鲁棒性。

总之,深度神经网络作为一种复杂系统,在其应用和发展中需要注意诸多复杂性问题。ChatGPT作为一个基于深度神经网络技术的聊天机器人模型,将其应用于军事场景的过程中同样需要注意这些问题并采取适当的措施来提高模型的稳定性、可靠性。(北京蓝德系信息科技有限公司研究员丁术亮)

参考资料:

[1] Azaria, Amos.”ChatGPT Usage and Limitations.”(2022).

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!