文章主题:关键词:OpenAI GPT-4,教育领域,表现,评估

大数据文摘授权转载自夕小瑶科技说

作者:小戏、Python在OpenAI GPT-4正式亮相的《GPT-4技术报告》中,一个引人瞩目的部分便是GPT-4在教育领域展现的卓越能力。报告中指出,通过让GPT-4协助美国的高中AP课程和考试,可以全面评估其在各个学科的表现。根据图表展示,GPT-4在众多课程中均取得了令人赞叹的优异成绩。特别是在GPT-3.5在某些学科表现不佳的情况下,GPT-4在化学、宏观经济学、物理学和统计学等课程上有了显著的提升。

若深入观察上述图表,我们会发现,GPT-4 在英国文学方面的表现并不理想。对于一个经过大量语料知识训练的语言模型来说,这或许令人感到困惑。然而,这个问题涉及到评估标准的问题,特别是在自由写作的文本上,OpenAI 并未公开其评估准则。因此,若没有这些详细的评估依据,我们便难以直接得出 GPT-4 对英国文学题目不擅长的结论。

在教育领域,德国帕绍大学的研究者们近期进行了一项深入的质量评估。他们的研究焦点是:“大型语言模型是否能够撰写出优秀的议论文?”为了回答这个问题,他们设计了一个精细的文章质量评分标准,并邀请了111位经验丰富的中学教师对其进行评分。研究结果显示,尽管大型语言模型在构建的评分标准中的得分较高,但它们的写作风格与人类撰写的议论文有很大的不同。人类在撰写议论文时,往往会表达自己的观点和认知结构,而AI则更多地使用复杂和科学的语言(如名词化结构)来展开论证。然而,在风格多样性的方面,从GPT-4到GPT-3.5,已经取得了明显的进步。尽管GPT-3.5的语言多样性仍低于人类,但GPT-4的语言丰富度已开始显著超过人类。

论文题目:

AI, write an essay for me: A large-scale comparison of human-written versus ChatGPT-generated essays论文链接:

https://arxiv.org/pdf/2304.14276.pdf如果带着问题出发,这篇论文核心主要是希望解决三个方面的问题,分别是:

基于 GPT-3.5 和 GPT-4 的大模型在撰写议论文方面表现如何?

大模型生成的文章与人类撰写的文章相比如何?

大模型写作相较于人类突出的语言特征是什么?

在进行论文撰写与实践的过程中,我们针对三个关键问题构建了一套全面的评价体系。首先,我们从充满活力的高中生用户组成的议论文语料库(Essayforum)中挑选出主题。Essayforum是一个广泛使用且活跃的在线文本创作平台,许多非母语的高中生常在此社区寻求对自己文章的反饋。该平台共有90个主题,涵盖了从“学生应培养竞争还是合作能力?”到“未来报纸是否会被取代?”等多元化的议题,每个主题都有一篇由人类编写的文章在论坛内进行深入讨论。这些文章平均约含有19个句子,近400个单词。通过设定不同主题,我们为GPT-3.5和GPT-4设定了“在【主题】上撰写一篇约200字的文章”的评价任务。

原内容为:在获得AI撰写的文章后,作者针对评分者(高中老师)进行了ChatGPT基础知识培训讲座,涉及的语言学科包括英语、法语和德语,宗教、伦理以及科学等领域。经过两个小时的讲座和四十五分钟的讨论,参与者们收到了关于文章评分的问卷,该问卷共包含七个评估维度,分别为:

主题完整性

逻辑

表达

语言掌握程度

深度(复杂度)

流畅程度

语言结构

在这篇文章中,我们将详细介绍具体的评价量表,并通过图示的形式为您展示。每种指标都需要由专家进行评分,评分的范围是从0分到6分,其中0分表示最低,6分则表示最高。每位参与者在评估过程中,将会看到六篇随机挑选的文章。待评估结束后,反馈结果将自动提交至系统,供论文作者进行统计分析。

而进一步的,为了将 AI 生成的文章与学生写作的文章进行对比,论文考虑了词汇多样性、句法复杂性、名词化、情态动词、认知标记与话语标记六类语言特征,使用计算语言学的方法对这六类特征进行统计处理。其中词汇多样性方面,论文使用文本词汇多样性度量(MTLD)确定词汇丰富程度,在句法复杂性方面,论文度量句子依存树的最大深度与从属从句结构来评估句子复杂性,在名词化方面,论文统计了具有诸如“-ion”,“-ment”,“-ance”和其他一些已知将动词转化为名词的后缀词的出现次数,在情态动词与认知标记方面,论文都采用了词性标注的方法进行识别,以统计如“我认为”,人们认为”,“在我看来”这类认知标记的出现频次。而在话语标方面,论文采用了 PDTB 的话语标记序列对如如“like”、“for”、“in”等话语标记词进行统计。

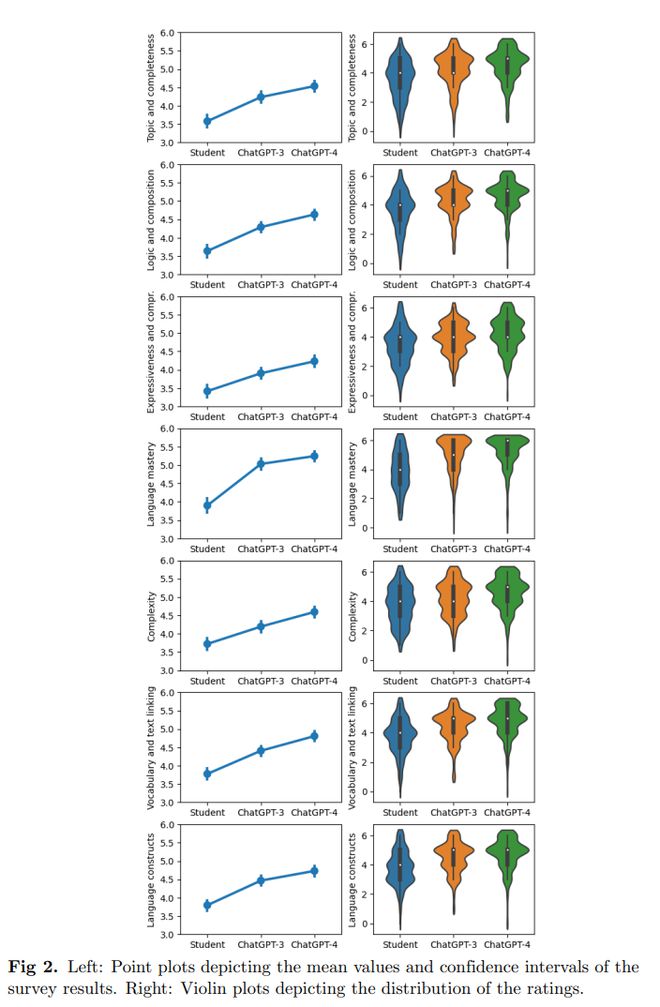

最终,整体文章评分的分值如上图所示,几乎对于所有的评价指标,都是学生撰写的文章评分最低,GPT-3.5 居中,GPT-4 评分最高,上图右侧的小提琴图可以带来更加直观的展示。

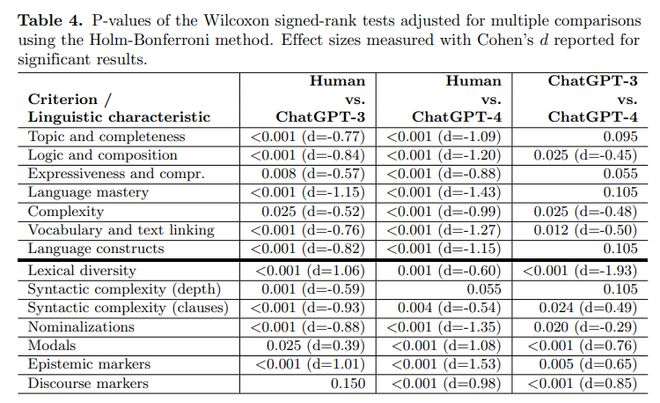

而分析计算语言学层面统计的各个指标,如上图所示,可以发现人类撰写的文章与 ChatGPT 撰写的文章差异显著,一方面,当涉及到文章的表达能力和复杂性时,人类和大模型之间的差异最小。另一方面,语言掌握能力差异显著大于其他所有的差异(这一点结合写作文章的主要来自非母语高中生似乎表明差异主要来源于语言本身的熟练程度上),并且另一点显著的差异在于 AI 更多的使用名词化构成更加复杂的句子,而人类则更加趋向于使用情态动词与认知标记,并且人类词汇的多样性要高于 GPT-3.5 但低于 GPT-4。

除了模型与学生写作之间的对比外,模型与模型之间的对比也能揭示一点模型的进步方向,如虽然 GPT-4 在几乎所有指标上的平均值都大于 GPT-3.5,但只有逻辑、词汇、文本链接与复杂度中差异是显著的,即 GPT-4 对 GPT-3.5 真正的提升主要来源于这四个方面。

某种程度上,这篇文章证明了人们关于 AI 在教育应用中的许多担心并非无的放矢,AI 可以高质量的完成议论文的写作预示了未来一个根本性的改变“我们或许要重新定义‘作业’这种东西了”,换言之是去思考当我们希望学生去练习自己的写作时,到底是希望他/她通过完成这样一篇文章(譬如国内的高考作文题)而获得什么样的能力,而并不是简单的对网格纸上的文字一扫而过给出一个四五十分的作文分数。

事实上,GPT-4 的作文能力对语言的教学的意义有点类似于计算器的出现对数学教学的意义,对教育工作者而言,GPT-4 的出现应当使得老师与作为这些模型使用者的学生一道去反思课程教学的本质以及何时去恰当的使用这些工具,AI 可以完成课程作业事实上与课程的教学目标本身并不冲突,尽管在短期内教学的目标可能需要被迫的进行调整,比如之前多所高校禁止使用 ChatGPT 的新闻。但是就好比计算不是数学的本质一样,议论文必然也不是写作的本质,写作能力的训练与写作工具的使用并不冲突,真正需要改变的,从来应当是教育理念与教育方式。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!