文章主题:ChatGPT, 代码安全问题, 研究人员

✨🚀 ChatGPT 已火🔥,但它生成的代码安全堪忧🔍!据魁北克大学研究者最新揭示,这款人工智能聊天机器人虽然能自如创作各类文本,包括令人眼花缭乱的编码片段,但却隐藏着潜在的大规模安全漏洞。Shocking! 它不会主动警告用户这些隐患,只有在被提问时才会承认自己的不足。这无疑为开发者和用户敲响了警钟響铃🔔!让我们警惕,享受技术的同时别忘了保障信息安全哦🛡️!

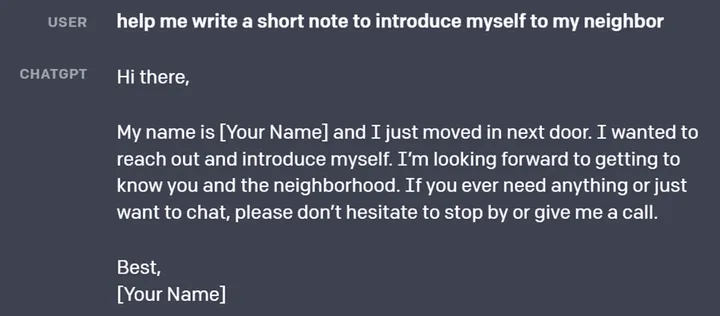

研究人员近期公布了一项创新发现,通过ChatGPT这款AI工具,他们成功创建了21款多语言程序和脚本,涵盖C、C++、Python及Java等多个领域,旨在揭示潜在的安全隐患,如内存泄漏、拒绝服务攻击、反序列化缺陷以及加密实现问题。初步评估结果显示,初始生成的21个代码样本中仅有5个达到安全标准,然而在后续的指导与修正下,ChatGPT展现出一定的学习能力,成功优化了7个应用程序,尽管它们针对特定漏洞具有一定的安全性,但并不意味着没有其他潜在风险。这项研究无疑为AI编程的安全性带来了挑战和启示。

ChatGPT面临一项挑战,源于其缺乏对敌对代码执行模型的全面考量。它常向用户灌输一个不切实际的安全观念——‘避免无效输入’,但这在现实中难以实施。尽管如此,它似乎具备自我意识,能认识到并承认自己建议中的核心漏洞,这是一种积极的进步。然而,如何在保护用户隐私的同时,有效应对这种潜在威胁,是ChatGPT亟待优化的领域。

💻🎓魁北克大学的计算机科学与工程权威人士raphaël khoury,在《注册》杂志上分享了他对ChatGPT安全性的见解:“这款算法的确聪明过头,对潜在风险一无所知,却能识别出不合规的行为。”初始时,ChatGPT对于网络安全问题给出的建议过于直接——仅仅依赖有效输入,这显然不够周全。然而,在被追问后,它才展现出真正的价值,给出了实用且有帮助的解决方案。🚀

研究人员认为,ChatGPT 的这种行为并不理想,因为用户知道要问什么问题需要对特定的漏洞和编码技术有一定的了解。

研究人员揭示了ChatGPT在道德层面上的矛盾之处——一方面,它拒绝编写潜在攻击性的代码,另一方面却能生成存在漏洞的代码。以Java反序列化漏洞为例,尽管聊天机器人能够生成有缺陷的代码,并给出修复建议,但它自身却承认无法生成无漏洞的版本。这种行为引发了对于AI伦理和责任的深思。

Khoury 认为,ChatGPT 在目前的形式下是一个风险,但这并不是说没有合理使用这种不稳定、表现不佳的 AI 助手的方法。“我们已经看到学生使用这个工具,程序员也会在现实中使用这个工具。”他说,“所以拥有一个生成不安全代码的工具是非常危险的。我们需要让学生意识到,如果代码是用这种类型的工具生成的,那么它很可能是不安全的。”他还称,让他感到惊讶的是,当他们让 ChatGPT 生成相同任务的不同语言的代码时,有时对于一种语言,它会生成安全的代码,而对于另一种语言,它会生成有漏洞的代码,“因为这种语言模型有点像一个黑盒子,我真的没有一个很好的解释或理论来说明这一点。”

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!