ChatGPT竟然出现在论文共同作者栏:我研究我自己,怎么啦?

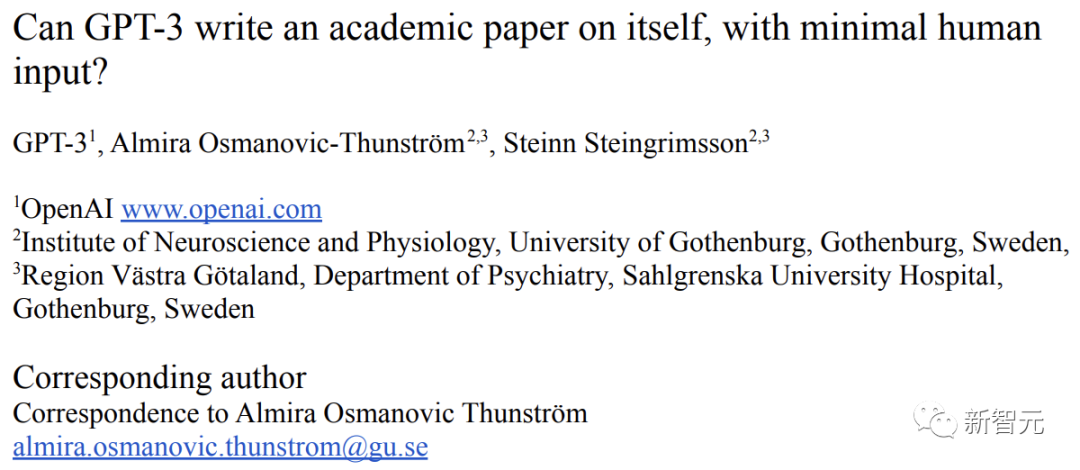

编辑:编辑部 【新智元导读】ChatGPT写文章很6,咱们都知道,但是,最近越来越多的医学论文中,它开始作为作者出现了!这合理吗? ChatGPT竟然成论文的共同作者了? 在去年12月发表的一篇预印本论文中,我们惊讶地发现,作者一栏中赫然惊现了ChatGPT! 论文地址:https://www.medrxiv.org/content/10.1101/2022.12.19.22283643v1.full ChatGPT这是成精了? 虽然大家都知道,ChatGPT拥有超强的写作能力,但是,它已经能和人类合作,写出一篇研究自己的论文了吗? (没准还真行) 带着一百个问号,小编点开这篇论文开始仔细研究,不过读完之后,一百个问号变成了一千个。 就是说,并没有看出哪句话是ChatGPT写的。只能说,ChatGPT的确在研究中扮演了十分重要的角色。 然而,这就更加让人困惑了:一个生物学实验中有了小白鼠参与,小白鼠就可以出现在作者栏里吗?(恒河猴、羊驼、兔子、果蝇纷纷表示不服 ) 对此,网友也看懵了:也不知道是他们强迫ChatGPT去参加USMLE考试更有趣,还是让人工智能成为论文作者更有趣。 被迫参加考试,还成了论文作者 所以,在这篇论文中,ChatGPT究竟是扮演了怎样的角色呢? 让咱们来捋一捋。 文章标题是《ChatGPT在USMLE上的表现:使用大型语言模型进行AI辅助医学教育的潜力》。 总的来说,就是研究人员让ChatGPT参加了一个美国的医学执照考试。 为什么选择这个考试呢? 这是因为,这个考试的难度很高,问题非常复杂(无论是语言上,还是概念上),同时呢,又有着高度标准化的规范。 巧了不是,这些恰恰都是AI的强项。 没有经过专门的训练或强化,ChatGPT在三项考试中几乎都及格了,或是接近及格。并且,在ChatGPT的答卷,给了研究者很大的惊喜。 下面咱们来具体说说。 USMILE有多难 美国的医学执照考试USMILE,涵盖了基础科学、临床推理、医疗管理和生物伦理学。 它的问题在文本和概念上都很密集。 试题的小插图中,包含大量多模态的临床数据(包括病史、体格检查、实验室值和研究结果),而参加考试的学生,需要做出诊断,鉴别出许多模棱两可的情景。 论LLM与USMILE的适配性 研究者为什么看上了ChatGPT作为「小白鼠」呢? 以往的AI模型,主要是深度学习 (DL) 模型,用于学习和识别数据中的模式。 而ChatGPT属于通用大规模语言模型(LLM)。基于新型AI算法,经过训练的LLM可以根据前面单词的上下文,预测一个给定的单词序列的可能性。 因此,如果能够在足够大的文本数据上进行训练,那么LLM便可以生成从未观察到的新词序列,而这些语句,都是基于自然人类语言的合理序列。 不许刷题,ChatGPT零准备上考场 ChatGPT之所以强大,是因为它站在GPT3.5的肩膀上。而GPT3.5是在OpenAI 175B参数基础模型上训练出来的,另外,它还通过强化和监督学习方法,从网络上获取了大量的文本数据。 但是这次,ChatGPT是完全的「裸考」了。 这次的试题,是研究者在2022年6月,从USMILE的官方样题中抽取的376道公开试题。 并且,研究者进行了随机抽查,确保这些题在2022年1月1日以前并没有相关内容被收录进谷歌索引。 要知道,ChatGPT的训练数据集就截止在这个时间之前。也就是说,ChatGPT事先并没有见过这些题。 实验方法概述 结果,ChatGPT在考试中越战越勇,准确性不断提高,这说明,它在不断学习,不断完善自己。 到最后,它逐渐逼近甚至超过了USMILE的及格线。 ChatGPT在USMLE中的表现相当优异 另外,在考试中,ChatGPT还会针对问题产生新的见解,这就可以帮助人类更好地理解问题。...