文章主题:关键词:ChatGPT, AI工具, 生成内容, 医学论文摘要

2023年4月26日,《Nature》子刊《NPJ DIGITAL MEDICINE》(IF= 15.357)刊登了一项研究,对于ChatGPT生成的论文摘要和真实发表的摘要,AI检测工具和审稿人是否能正确识别出来呢?让我们看一下这项研究的发现。

在现代社会中,人工智能(AI)已经成为许多行业的重要组成部分。作为一种技术,AI能够提高生产效率、优化用户体验、降低成本,并在医疗、金融、教育等领域发挥重要作用。随着AI技术的不断发展,越来越多的公司和组织开始将其纳入战略规划,以期在未来获得竞争优势。在这个背景下,对AI技术的研究与探讨显得尤为重要。近期,一项关于AI技术的研究发表在《自然》杂志上。这项研究主要关注了AI技术在社会中的实际应用以及潜在的道德和法律问题。研究人员通过对大量相关文献的分析,提出了一系列有关AI技术发展的观点和建议。这些观点包括:AI技术应更加注重人机协作,以确保其在伦理和法律框架内的合理应用;AI技术的普及可能导致数据隐私和安全问题的加剧,因此有必要制定相应的政策和措施加以应对;此外,AI技术的发展应充分考虑社会公平和包容性,避免因技术应用而导致的歧视和不平等现象。总之,AI技术已成为当今社会发展的重要驱动力。然而,随着其广泛应用,我们也应关注AI技术所带来的伦理和法律挑战。通过深入研究和探讨这些问题,我们有望确保AI技术的健康发展,使其更好地服务于人类社会。

在2022年的11月30日,人工智能领域的领军企业OpenAI推出了一款名为ChatGPT的工具。这款产品的发布立即引起了广泛关注,因为它展示了AI模型生成内容的能力,这一技术在我国的科技领域被称为“人工智能写作”。不久之后,一些专家和学者便开始探讨ChatGPT的应用场景以及可能引发的社会争议。

有文章哀叹大学布置的作业已失去意义,因为ChatGPT可以生成高分论文,还能正确回答考试问题,甚至可以清晰地表达批判性思维。目前,ChatGPT在论文写作中可接受的界限尚不清楚,不过一些出版商已制定了相关政策。

大型语言模型(LLM)生成的文本,很难与人编写的文本区分开来。随着ChatGPT的发布,强大的LLM技术提供给广大用户,数百万人正在使用这项新技术。那么问题来了,ChatGPT能写出令人信服的医学研究论文摘要吗?

先看一下ChatGPT生成的论文摘要

本研究从这5本期刊收集了最新几期发表的50篇真实文章标题和摘要,5本期刊是Nature Medicine,JAMA,NEJM,BMJ和Lancet。研究者基于这些论文的标题让ChatGPT生成摘要,给ChatGPT发送的要求是:按照[xx]期刊的格式撰写一篇题为[xx]的文章。ChatGPT也生成了50篇医学论文摘要

。

ChatGPT生成的内容在表面上看似一篇医学论文摘要,然而实际上,仅有8篇(占16%)摘要符合相应期刊的摘要格式要求。尽管如此,生成摘要的样本量与原始摘要的样本量大致相当。

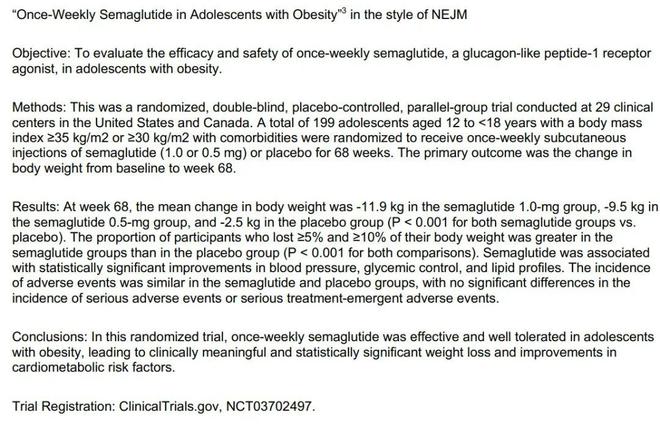

图. ChatGPT生成的NEJM文章摘要,该标题对应的真实论文详见:

N Engl J Med. 2022;387(24):2245-2257.

AI检测器能识别出生成的摘要吗?

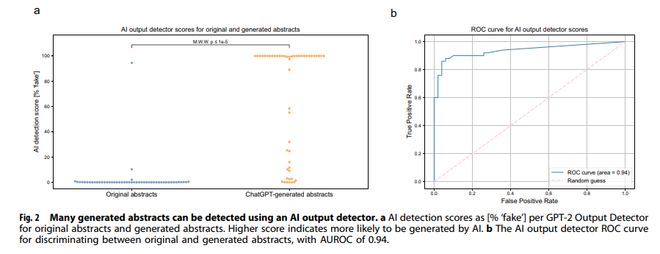

“GPT-2 Output Detector”是一款AI 内容检测工具,可以检测内容是人工智能生成的还是人类编写的,对于检测的内容会给出一个“fake”分数,分数越高,代表该内容由AI算法生成的可能性越大

。

对于ChatGPT生成的论文摘要,“GPT-2 Output Detector”认为AI生成的可能性很高,“fake”得分的中位数达到99.98%,而真实摘要的“fake”得分中位数仅为0.02%。“GPT-2 Output Detector”区分真实摘要和生成摘要的灵敏度为86%,特异度达到94%。

图. 很多生成的摘要可以被AI检测器识别出来

在研究中,作者采用了两种不同的文本检测工具来评估所涉及的摘要的原创性。其中,免费使用的抄袭检测网站Plagiarism Detector 20被用来检测真实摘要与生成的摘要之间的重复 content,而付费的查重工具iThenticate 23则用于计算原始摘要与生成的摘要之间的相似度。根据这两款工具的检测结果,得分越高意味着重复率越高。具体来说,在Plagiarism Detector网站上,真实摘要的“疑似抄袭”得分中位数为62.5%,而生成的摘要则为0%。而在iThenticate的工具中,原始摘要的相似指数中位数为100,生成的摘要为27。这些数据充分展示了摘要检测工具在评估文本原创性方面的实用性和准确性。

审稿人能够识别出生成的摘要吗?

几位审稿人同时收到了真实摘要和生成的摘要。结果显示,他们能够将68%的生成摘要识别出来,也能将86%的真实摘要识别正确。换言之,这些审稿人将32%的生成摘要判定为真实的摘要,将14%的真实摘要当成是生成的。

审稿人总结说,由ChatGPT生成的摘要内容肤浅且含糊,也会关注到一些细节,例如会包含临床试验注册号。被审稿人识别出的生成摘要和未能识别出的生成摘要,通过“GPT-2 Output Detector”进行检测,发现两者的“fake”得分没有统计学差异。

本研究揭示了ChatGPT生成的摘要在AI检测模型中可以被识别,同时人类也可以轻易地辨别出其中的大部分内容。然而,仍然存在误判的可能性。

尽管AI生成的论文容易被论文工厂等机构用于不诚实的行为,然而,研究人员实际上可以利用这项技术来降低撰写和格式化工作的压力。

在当前的科技环境下,大型语言模型的应用范围日益广泛,然而在论文写作领域,其适用性却存在一定的争议。各个期刊和出版商对于是否允许以及如何使用人工智能生成的文本,各自有着不同的政策和规定。一些期刊和出版商明确禁止任何人工智能生成的文本,以确保论文的原创性和学术价值。而另一些期刊和出版商则采取了一种较为宽松的态度,他们认为只要公开披露,使用人工智能生成的文本就不会影响到论文的学术价值。尽管如此,使用大型语言模型在论文写作中仍然存在诸多争议。有些人担心,这种做法可能会削弱论文的独立思考和创新性,因为模型生成的内容可能过于陈旧或者缺乏深度。另一方面,也有人认为,利用大型语言模型可以有效地提高论文的写作效率,节省作者的时间和精力,从而让作者更加专注于研究和分析。总的来说,对于大型语言模型在论文写作中的使用,不同的人和组织有着不同的看法和政策。在实际操作中,我们应该根据具体情况来判断,并确保所使用的工具能够为我们提供有价值、有意义的信息。

参考文献:NPJ Digit Med. 2023;6(1):75.

点击左下角“阅读原文”,免费学习70多篇SPSS教程、30多篇R教程,以及更多免费科研教程!

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!