文章主题:OpenAI, ChatGPT, 大语言模型, 人工智能

对于OpenAI训练的大型语言模型ChatGPT的热度,我们需要保持冷静的理智态度。虽然从技术层面来看,它的表现可能会让人印象深刻,但是依赖机器进行对话以及生成的响应,这种想法却引发了我们应该深入思考的严重关切。

作为一名文章写作高手,我会以专业素养对原文进行改写。原内容提到 ChatGPT 无法深刻理解人类语言和对话的复杂性,仅仅将其视为简单的输入输出任务。然而,这种理解对于真正有效地进行对话交流至关重要。因此,ChatGPT 的这种局限性使得其生成的回应可能不够深入、缺乏洞察力和深度。

除了引发道德问题之外,过度依赖ChatGPT进行对话还可能削弱人际关系的价值。作为人类的基本社交技能之一,与他人进行有效沟通的能力在很大程度上取决于我们与他人的真实互动。而将这一过程完全交给机器可能会导致我们在建立和维护人际关系方面的能力退化。更甚的是,这种依赖性可能导致人们在现实生活中逐渐丧失与他人面对面交流的勇气和技巧,从而使人类社会陷入一种不利于发展的困境。因此,在使用ChatGPT等人工智能技术时,我们需要审慎对待,确保其在提供便利的同时,不会对我们的生活产生负面影响。

互联网,以及它赖以生存的整个技术领域,感觉就像是一个巨大的胡说八道的器官——用于扩大人类对言论的访问和放大谎言。在网上,人们互相欺骗、欺骗和小冲突。深度学习 AI 通过隐藏 LLM 等软件的操作使这一切变得更糟,以至于没有人,甚至是他们的创造者,都无法解释他们在做什么以及为什么这样做。OpenAI将其工作展示为无上下文和实验性的,没有特定的用例——它说它发布 ChatGPT 只是为了“获得用户的反馈并了解其优势和劣势”。难怪关于 ChatGPT 的第一个也是最明显的假设是它是一种威胁——对某些东西,对一切。

ChatGPT并非通向理解所有人类知识和文本的通用人工智能之路上的必要一步,它仅仅是一种掌握并运用这些知识和文本的工具。这种工具就像一个游戏,其中玩家利用熟悉的原材料,以意想不到的方式创造出新的东西。比如,法学硕士并不会替代大学、杂志或者中等管理人员,但它们确实为这些领域以及其他领域提供了一种全新的工具,一种能够处理大量文本材料的词汇。

在与ChatGPT的对话中,我们探讨了诸多领域,如诗歌、行为心理学以及计算机编程等,目的在于验证该理论的正确性。当前,ChatGPT仅是一个技术展示和实验阶段,其未来可能带来的技术变革尚不可知。尽管在许多场景下,人工智能具备了获取和表达知识的能力,但在某些情况下,机器人不得不承认自己正在捏造事实。

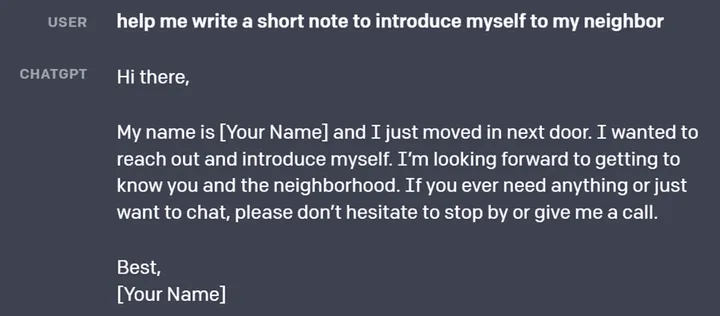

有时候,AI 工具仅仅只是利用模板。以 ChatGPT 为例,当被我要求为其撰写一封大学工作的求职信时,它以一种尽职尽责却略显平淡的态度完成了任务。甚至在与杂志编辑职位以及 Web3 领域大麻创新者职位的信件中,它都采用了完全相同的表述(“我对 Web3 空间及其所引发的独特挑战与机遇有着深入的理解”)。这种现象相当公平,因为大多数求职信都在不断地重复着那些陈词滥调的词汇和抽象的概念,而这些都显得相当糟糕。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!