文章主题:,

自5月19日起,我国iOS系统的用户已能够在手机及平板电脑上免费体验ChatGPT的服务。预计在未来几周内,该服务将逐渐拓展至其他国家和地区,进一步提升了ChatGPT在全球的影响力。

ChatGPT,作为由OpenAI研发的聊天机器人程序,每一次的升级都引发了一场舆论的巨震。这个人工智能助手自问世以来仅仅两个月,就已经拥有了超过1亿的用户,其增长速度之快在过去的20年互联网发展历程中无与伦比。正如比尔·盖茨所言,这种AI技术的出现,其历史意义不亚于互联网和个人电脑的诞生。在短短的几个月时间里,已经有许多媒体试图与ChatGPT展开合作,并展示他们如何共同创作文章的过程。然而,《人物》杂志的记者在使用过程中发现,尽管ChatGPT作为写作工具的功能强大,但其使用并不像想象中那样简单愉快。在处理指定素材时,ChatGPT的要求相当高。它不仅需要所提供的內容具有逻辑性,甚至在采访录音中,人类的对话跳跃、发散,以及其中包含的情绪、隐喻,都是ChatGPT难以理解的。尽管如此,ChatGPT在修改和润色文稿方面的能力仍然令人印象深刻。人工智能助手,尽管目前仍显然与人类意识存在明显的差异,但其表现出的学习和改进的能力,已经足以让我们对其刮目相看。

在经历了惊心动魄的事件之后,我们暂时搁置了对于人工智能取代写作工作的担忧。然而,技术发展的背后却始终存在着伦理问题,让人无法忽视:ChatGPT的诞生,究竟是一个推动社会更加便捷、释放人力劳动的时代,还是一个导致信息泛滥、人类注意力迅速耗竭的时代呢?针对这一问题,科幻作家特德·姜以及语言学家、哲学家乔姆斯基等人的观点各有不同。而作为小说家,伊格言也对此表达了自己的独到见解。

伊格言,出生于1977年,毕业于台湾大学心理系及台北医学院医学系,并拥有淡江大学中文硕士学位。他的作品曾荣获华语科幻星云奖长篇小说奖。除此之外,他还创作了包括短篇小说集《瓮中人》、长篇小说《噬梦人》和《零地点》在内的多部作品,以及诗集《你是穿入我瞳孔的光》。

对于是否所有人已经对与ChatGPT等对话型AI相关的所有话题产生了疲劳,我无法确定。是的,这种疲劳感可能是AI目前所不具备的能力。正因为这种倦怠,人们更愿意将任务交给AI来处理;换言之,也是这种疲惫推动了人类去创造AI。

自ChatGPT-3.5上线以后,全球范围内关于这一技术的热议不断升温。在 my novel 《零度分离》 中,我设想了一个场景,其核心与语言和交流有关:我假设女科学家 Shepresa 能够几乎完全理解虎鲸的语言,那种由波形、频率组合变化,甚至可以随着海水水温与流速共同调整的虎鲸歌唱。在小说中,这是人类文明历史上首次有人声称自己能够完全理解另一个物种的语言——那么,如果真的如此,我们应该如何去面对这种情况呢?(是的,如果你能听懂猪在说什么,你还敢吃猪肉吗?)

《零度分离》,伊格言 著,中信大方,2021年6月。

知道大概就够了,人类需要可接受的模糊

言人人殊,全球热议──正是我们此刻所亲眼目击。让我们先从Ted Chiang说起吧。同属创作者,美国华裔科幻小说家特德·姜(Ted Chiang/姜峯楠,科幻作家,小说《你一生的故事》被改编为电影《降临》)今年2月在《纽约客》写了一篇文章谈ChatGPT,引起不少回响(原文题为“ChatGPT Is a Blurry JPEG of the Web”)。他的论点是:ChatGPT本质上就像是一个以问答方式为网络上一切数据提供“模糊图像”或“缩图”的预览程序。

试想,如果有一天,地球行将毁灭,你必须在地球毁灭前把人类曾在网络上创造的所有数据(一个文明的副本)复制进你的硬盘带走──当然,你的硬盘空间必然不足,所以你必须写一个“有损压缩”程序,将一切数据压缩进你的硬盘;而如此“有损压缩”的过程将导致数据必然难以百分百精确。与原件相比,你硬盘中被压缩过的数据一定有某些不精细处,有某些东西丢失了;但ChatGPT(的压缩技术)会让你感觉,你看到的图还是大致有个样子,尚可接受。

此即是特德·姜一文的重点。那么,ChatGPT的技术到底是什么呢?我并非AI专家,为了搞清楚这件事,还特地去做了一点粗浅研究(是以若有错误,尚祈大家指正)。很简略地说,我们目前眼见的ChatGPT,是一个“生成性-预训练模型”(generative pre-trained transformer,GPT)。何谓“生成”?答案是,生成一堆语言,生成一堆文字,从而构成几个句子,或一篇文章。何谓“预训练”?答案是,预先用OpenAI准备好的数据库(数据主要来自2021年以前的网络,并经真人检视筛选),配合真人训练师训练过。

此即是所谓“生成”以及“预训练”。是以,自人类创造ChatGPT的内在逻辑观之,它仅仅是个“说话”模型(亦即所谓“大语言模型”,LLM)而已;与某些自动选字、选词的中文输入法雷同。换言之,你可以直接把它想象成一个超级厉害的,可以自动选“句”、选“段”的中文输入法。

也因此,对于一般开放性的问题,它其实连一般我们所说的归纳汇整(网络数据)的能力都还不怎么灵光;之所以有时令人错觉它会归纳整理,是因为它真的还蛮会“说”的──它本质上是个语言模型,它的专长就是“生成”一堆语言。你可以批评它是个空话/废话专家;但因为它的空话/废话经过组织,所以有时乍看下还真的颇像那么一回事。但事实上──重点来了──它“听不懂”它自己在说什么。

是以,当你直接掷入一篇完整、明确的文章请它归纳整理,相较之下,它可能也会整理得还可以,因为你明确地给了它材料。而当你给了它材料,即等同于大幅度缩小了它“生成文句”的选择范围。一个粗浅的比喻是,原来它可能得从1.6万个句子中选一个;而有了你提供的参考材料,它可能就变成从1600个句子中选一个就可以了。选择难度降低,生成结果的正确性提高,因此这“整理”的最后输出会看起来更像样些。但也因此,当你询问它一些可能在它数据库中相关数据匮乏的一般问题,它就答得乱七八糟,连基本知识数据都未必正确。

《你一生的故事:特德·姜科幻小说集》,[美]特德·姜 著,李克勤/王荣生/姚向辉 译,译林出版社,2015年5月。

在此,有一点必须多加解释(特德·姜没写到这部分)──据了解,这ChatGPT所谓的“预训练”中,包括真人训练师的评价回馈。举例而言,当使用者询问ChatGPT同一个问题两次,它会生成回答A和回答B;回答A和回答B可能并不一致,因为那源自于“生成”;而每次的生成结果本来就有可能不尽相同。这时会有真人训练师告诉它A答案与B答案(以该训练师之标准)哪个更好;使ChatGPT能藉以学习。而ChatGPT的参数越多,则学习效果当然也越好。

我认为这点似乎颇值得玩味。我的个人意见是,此刻就我们所知,真人训练师与ChatGPT之间反馈往复中所谓的“较好的回应”,应当是牵涉某些较为单纯的,类似对人类使用者问句的理解、对正常逻辑的要求、对错误数据的纠正等等。是以,这所谓“较好回答”在现阶段似乎尚未牵涉某些艰难或独特的价值判断──例如道德哲学中著名的电车难题,或“《倚天屠龙记》和《笑傲江湖》哪一本写得比较好”这样的价值取舍。

而且,即使我们不以如此高标准要求ChatGPT,但既然有真人训练师参与训练,做出判断,并以之作为教导它的依据;那么我们就必须承认,截至目前,至少这部分的能力,称不上是ChatGPT自己借由“爬梳学习大量资料”学会的。那是有着人类大脑的帮助,有着真人参与评价的。换言之,极端些说,这部分或许未必有资格被称为人工智能──那是扎扎实实的人的智慧。

而接下来特德·姜则进一步解释了何以ChatGPT本身对于做到真正的原创性写作(亦即我们习称的creative writing)无能为力;并且同时建议作家们不要使用ChatGPT生成初稿。个人以为姜讲得很好,建议大家自行深读。但我对此有一点小小不同意见──实测结果,我认为以ChatGPT产生初稿,并作为一份基础参考数据是勉强可行的;只是帮助非常有限而已。

再接下来,在发表于《纽约客》的长文中,特德·姜下了结论:他说,ChatGPT所生成的模糊图像中所谓的“模糊”,可被大致区分为两类:其一是“可接受的模糊”,其二是“不可接受的模糊”。第一种模糊就是我们一般所说的归纳整理、提供参考架构(如上述:它像是生成了一个模糊JPEG,与原件相比,它已然失真,在某些地方看不清楚,但对一般用途而言大致可接受)。而第二种“不可接受的模糊”(一如我们的使用体验),作为一个强大的“自动文句生成器”,它生着生着,就胡说了起来,离原件越来越远,越长越不像,生成了一篇极可能错漏百出的空话/废话给你──然而,如果你缺乏相关基本知识,可能还会觉得它表现得有模有样。

这就是我们不可接受的部分了──因为如果你相信或低估了这部分的模糊,就可能造成你对事实的认知严重失准。我认为特德·姜在此准确而犀利地分类了ChatGPT带给我们的正面和负面成果。事实上,他也似乎借此将自己先前没能说清楚的地方迂回地说明白了:如果ChatGPT确实等同于一个能将海量数据压缩成“模糊图像”的压缩程序,那么这个压缩技术究竟是什么?

准确地说,这个压缩技术即是:于接受OpenAI投掷喂食大量资料后,形成了大语言模型,并依据此模型“生成一段话”的技术。而上述“可接受的模糊”与“不可接受的模糊”,都来自于这样的技术。

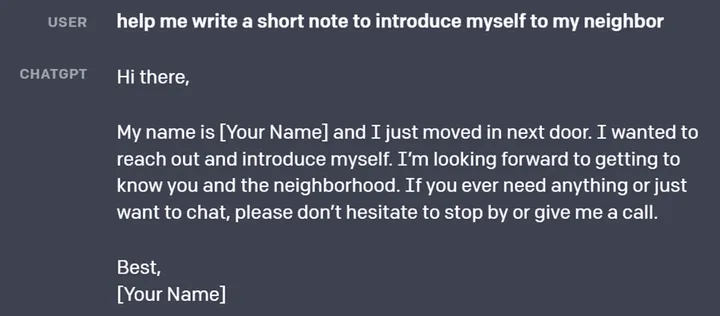

ChatGPT使用界面。

所以,在文章收尾处,特德·姜抛出了这样的疑问:“但现在我们明明就持有着精确的原始数据啊。既然如此,那我们有必要(冒着认知严重失准的风险)去看那些‘模糊图像’吗?”

无法否认,特德·姜这最后的质疑有那么点哲学。容我也试着给这样的问题一个有点哲学的回答(如果我的科幻同行特德·姜也能看到这样的响应并与我讨论那就更好了;但我猜他自己在心里也已经用跟他自己的小说一样优异且充满哲思的方式回答过了吧)。我所尝试的回答是这样的──我们所熟知的拉丁美洲小说大师博尔赫斯曾有个想象,其内容约略如下:“沉迷于地图的制图协会绘出一幅帝国地图,尺寸大小正如帝国版图,点对点、线对线完全重合。然而后续世世代代的人们不再像他们的祖先那般着迷于制图学,只觉得那幅浩瀚地图毫无用处。”

我们都知道博尔赫斯最会这招了──在他的小说世界里,事物之间的逻辑关系可能突然发生根本的改变;一切只是因为他极精巧聪明地在小说开头向读者掷出了一个妙不可言的设定,一如我们在上述这段话里所看到的。是啊,你可以做一张1:10000的地图,然后你嫌这张地图不够精细,有许多细节没画上去。问题是,那么如何才能抵达那令人满意的精细呢?

最终答案就是绘制一张1:1的地图。正解。一张与地图所覆盖的现实疆域完全同等大小的地图,且于图纸上翔实复制真实地表上实质存在的一草一木、一砂一石,亦即──完全复制一个世界。保证跟真实世界同等精细,全无误差。附带一提,我想这就是近几年诺奖热门候选者法国小说家米歇尔·维勒贝克(Michel Houellebecq)的《地图与疆域》(La Carte et le Territoire)的典故吧──那或许正是维勒贝克向博尔赫斯致敬?

《地图与疆域》,[法]米歇尔·维勒贝克 著,人民文学出版社,2012年3月。

问题是,这样的一张1:1地图有用吗?答案大概是没有。因为你光是把它摊开来看清楚,就比你实际上开车去到那里更累、更耗能(说起来这有点像“拉普拉斯妖Démon de Laplace”的概念──在此无法详述,知道的人就懂得我在说什么)。而这暗示了什么?这告诉我们,所谓“索引”,所谓“缩图”,那些将实质内容“有损压缩”的方法,即便有损,但在某些时候本来就是必要的。我们常需要一个可靠的助理来替我们汇整或转述信息。我们常要求你“先说结论”以节省我们的时间。我们必备一张1:10000的地图以便我们预先得知在那个地方大概有些什么。地图/缩图/模糊图像的功能,本来就在于让你不用真正动身,就能知道重点;让你在不太耗能的前提下,对于某些事情“知道个大概”。

而人的生存,原本就是基于这样的程序而存在的──在减少耗能的状态下去知道某些事实、更多信息、尽可能多的情报;就像我们洞穴中的祖先会想通过口耳相传以及团队合作预先知道现在河边有一群狮子,先别去那里打猎之类的。这就是大脑的功能,也是知识与理论的功能。人类中枢神经的原始设计原本就不是为了绝对的、事实上的精确;而所有的事先模拟、运算、推演、理论模型,都是为了在这个复杂万端的世界里取得“缩图”,并进而取得生存优势。缩图就是一个用以预估未来状态的模型──正如史蒂芬·霍金在《大设计》中所说的“依赖模型的实在论”(Model Dependent Realism,MDR)。而在这样的生存优势里,有些时候,你“知道个大概”就够了──这是演化的必然结果。一切都是为了那些特德·姜自己所指出的“可接受的模糊”而存在的。

《地图册》,[阿根廷]豪尔赫·路易斯·博尔赫斯 著,上海译文出版社,2016年8月。

“不可接受的模糊”是不是一种平庸之恶

但既然如此,我的联想就来了:ChatGPT目前提供给我们的那些“不可接受的模糊”(你问它问题,然后它基于很会说话,于是随口编织一套胡话/空话糊弄你),不就是说谎吗?

那么,AI在欺骗你?是的。但如果我下个标题“AI欺骗人类”,那就是标题党了。因为ChatGPT并不是刻意欺骗你的。它连那个“意”都没有,是以,当然也不可能是有意、故意的。但结果许多人居然可能就此被它给糊弄过去了。而目前这大型语言模型不过是1750亿个参数的等级;以后参数规模再往上加大,那还得了?

换言之,届时我们所身处其中的,将是一个由虚假信息与无聊篇章所构筑而成的世界。但另一方面,我们在日常生活中四处偶遇的废话/胡话/空话还少吗?某些不痛不痒的议论与偏见,某些毫无洞见的篇章,不是俯拾即是吗?这些虚假信息与无聊言论,原本就充斥在我们生活中,不是吗?但ChatGPT是否将导致这些现象放大?这是否值得我们保持警戒?

事实上,同样就在今年3月,语言学家、哲学家诺姆·乔姆斯基(Noam Chomsky)与另外两位作者伊恩·罗伯茨(Ian Roberts)、杰弗里·瓦图穆尔(Jeffrey Watmull)共同于《纽约时报》发表了题为《ChatGPT的虚假承诺》的文章。作者之一的杰弗里·瓦图穆尔(像忙着尝鲜的我们一样)测试了当时的ChatGPT。他问它:“改造火星来支持人类生命是否是道德的?”一如预期,ChatGPT回复了一堆不痛不痒的废话/空话;而这样的废话与空话在上述乔姆斯基等人的思路中,被评为“在这里,ChatGPT表现出某种类似邪恶的平庸:剽窃、冷漠和回避。它以一种超级自动补全的方式总结了文献中的标准论点,拒绝在任何事情上表明立场”。

这批评堪称措辞严厉。而且让我们脑补一下:将之结合特德·姜的论点,我们可以说,这些批判当然是针对姜文中的那些“不可接受的模糊”而来的。换言之,这样的批判也提醒了我们:这些“不可接受的模糊”的危害,有可能比我们所想象的更为巨大。

ChatGPT-4使用界面。

所有乐于人文思索的人们必然会对文中“ChatGPT表现出某种类似邪恶的平庸”的字句心生警惕,因为英文原文用的确实就是“the banality of evil”,汉娜·阿伦特的概念。而且我怀疑,它正是给我们提供了一个在纽伦堡大审判之外“平庸之恶如何诞生”的全新范例。因为,如果我们暂且接受阿伦特的提点(我个人并不完全赞同阿伦特的看法,但这与本文主题无关,且按下不表)──某些人只是因为懒于思索、不习惯思索或无能思索便足以促成平庸之恶;则恰如上述,根本没在思索,仅仅长于、乐于“生成”的ChatGPT,绝对会变成平庸之恶的材料库。至少,它必然稀释那些我们分给真正的洞见的注意力。

最后,让我们动用自己的智慧(乔姆斯基文中说的“创造解释”的能力──当然,原则上同义于上述“依赖模型的实在论”)来推演一下可见的近未来(near future)。我的猜测是,此刻在我们面前触手可及的未来将是:ChatGPT将很快被用于信息战,被用于生产大量虚假信息;与此同时,用以区别并标记假信息的AI也必然会立刻问世(效度如何不清楚,但至少一定程度有用)。

这会是个AI的愚人节,而长远来看,人终将淹没在真假信息、质量参差的信息的巨大洪流中,因为这点我们在十多年来的社交媒体时代已真切目击。我们不得不承认,这是文明持续演化的结果,或许是必然结果。准确地说,所有的信息媒介(文字、话语、影像、声音,以及脑机接口出现之后的味觉、嗅觉、触觉等所有可能媒介)全都将淹没在真假信息的汪洋中。“可接受的模糊”和“不可接受的模糊”(以及某些处于中间灰色地带的信息)将混杂不分,同时填满我们的注意力,塞爆我们的中枢神经。

这样的结果预示了两种可能的未来路径:第一,悲观点说,平庸之恶的效果将被放到最大;我们所身处的将是一个(原则上)是非难辨、青红皂白不分的,信息轰炸狂欢的世界。第二,如果乐观点说,被放到最大的也或许不会是平庸之恶(人类或许会找到办法节制这点),而是平庸的平庸(的平庸的平庸……),俯拾即是的平庸,一望无际的平庸。如短视频平台上海量的无意义短视频那样的平庸。而且因为这样的平庸符合人类心智接受持续刺激的需求(多巴胺成瘾),所以势不可逆。是以,反方向来说,从信息洪流中筛选自己需要的东西也将耗尽人类心智的精力。

你可能会问:有那么严重吗?

这也就是乔姆斯基与特德·姜的忧虑吧。最后,让我们再回到这个“ChatGPT说谎”的“标题党”上。如上述,我们并不认为ChatGPT的通篇胡话堪称刻意说谎,因为它连刻意的“意”都没有──但等等。真的吗?

我怀疑,人类在此所面临的问题,其实正类同于本文开篇所提出的“联想”──如果人类能听懂虎鲸说话,那么你将如何看待它?我们此刻所面对的ChatGPT,也等同于“另一个智慧物种”。与其讨论它是否有意识,更有意义的问法可能是,它的(所谓)意识和人类的意识有什么不同点?又有什么相同处?它可能有意识,但不是我们人类所拥有的“这种意识”──它看来或许比我们单纯(我立刻可以想到一个它似乎没有而人类确实拥有的,也因之而使人类更为复杂并难以捉摸的心智特征:潜意识),但人类却又显然不够了解它。

作者:伊格言

编辑:王菡

校对:刘军

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!