文章主题:ChatGPT, AI工具, 学术研究, 检测

chatGPT虽然很厉害,但还是有工具能够辨别出来。

chatGPT超强的论文写作能力

chatGPT这一段时间可谓是火遍了全球。

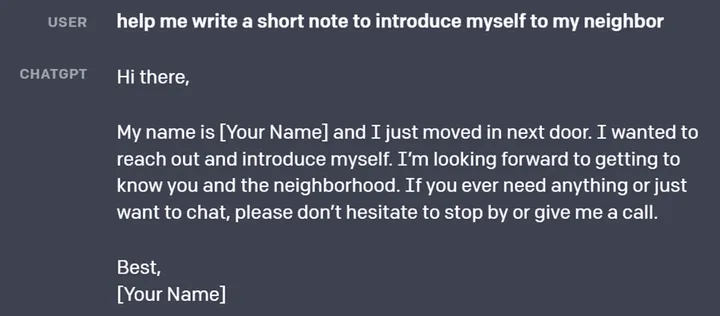

它在论文写作方面也展现出来了很强的实力,我们也对它的写作能力做了测试,我们让chatGPT 写一个关于粒子群算法的寿命预测论文摘要:

write an abstract about a pso algorithm for life prediction。chatGPT 的回答如下,大家可以自行判断 chatGPT 的回答效果。

This paper presents a Particle Swarm Optimization (PSO) algorithm for life prediction. The proposed algorithm uses an evolutionary approach to predict life expectancy by optimizing a set of parameters. The proposed algorithm is applied to a data set containing life expectancy information from a group of individuals. The results show that the proposed PSO algorithm can effectively predict the life expectancy of a group of individuals with high accuracy. Additionally, the proposed algorithm can be used to identify key factors that influence life expectancy, such as age, gender, lifestyle and socio-economic status. Furthermore, the proposed algorithm can be extended to other applications such as drug design, disease diagnosis and health monitoring. Overall, the proposed PSO algorithm presents a promising approach for life prediction.在我看来,针对仅提供论文主题摘要的要求,ChatGPT 的回应展现出了高度的专业性。尽管我们不能直接使用它的回答,但稍微进行修改后,它就能为我们节省大量的时间和精力。

chatGPT已经发表了署名论文

就如现在非常发达的翻译软件一样,我们现在翻译文献早已经不会逐字逐句进行翻译了,都是使用翻译软件先进行机翻,然后人工修改校正,大大提高了翻译效率。

经过我们上面的测试,chatGPT写出来的内容也已经到了仅需人工修改校正就能使用的水平了,可以想见不久的将来,人们也会利用chatGPT来生成论文初稿,然后自己在论文初稿的基础上在进行创作加工。

目前已经有不少作者成为了第一个吃螃蟹的人,由chatGPT署名的论文已经发表了。

学术界对于chatGPT的看法

目前使用ChatGPT一类的人工智能工具,还没有出台相应的规范化使用界限准则,而学术期刊的领头羊们率先明确发布了一些约束措施,如

Science期刊的主编强调,他们不会允许人工智能技术成为其发表的论文作者,并且认为在未给出恰当引用的情况下使用人工智能生成的文本可能存在剽窃之嫌。

Nature期刊的主编也明确说明:“任何大型语言模型(LLM)都不会被接受为研究论文的署名作者。这是因为任何作者的归属都意味着对研究工作的责任,而人工智能工具不能承担这种责任”。

论文的署名作者其实应该是对这篇论文内容作出贡献的人,而且是要对内容负责的,就好比有的期刊在最后转让版权是是要求一作和通讯签字,有的期刊则要求所有作者签字一样,chatGPT这类人工智能软件仅仅是在论文写作上提供了帮助,并没有对论文的发现作出贡献,它无法对论文内容负责,它也无法签字。

当前学术界普遍认为,像ChatGPT这样的工具无法成为合法的作者,但它并未被全面禁止。若要使用ChatGPT,则必须明确地进行声明。

chatGPT是可以检测出来的

有的小伙伴觉得chatGPT这么厉害是不是已经到了以假乱真的地步,但其实不然。

我们还可以用魔法来打败魔法。

既然人工智能能够生成文本,那我就用人工智能来检测文本是否是由人工智能生成的。

在本文的研究中,作者采用了创新的方法来测试人工智能助手chatGPT的摘要生成能力。首先,作者利用chatGPT根据各类期刊的特点生成了多个摘要样本,这种方法不仅展示了人工智能在不同领域中的广泛应用,同时也为评估其摘要生成的质量提供了有趣的视角。接下来,我们对这些摘要进行了查重分析,并与人工撰写的摘要进行了对比,以此检测chatGPT生成的摘要是否容易被识别为人工智能所产生。通过对这些摘要的仔细审查,我们旨在探讨人工智能在学术研究领域的应用前景,并对其可能存在的局限性进行深入探讨。

最后的结果是这些摘要都通过了查重,但是人工和人工智能检测器也都能够发现这些摘要不是真人写的。

这里使用的工具是GPT-2 Output Detector

我们也可以来简单测试一下

我用这篇论文中的句子先放进去检测了一下

Results All ChatGPT-generated abstracts were written clearly but only 8% correctly followed the specific journal’s formatting requirements. Most generated abstracts were detected using the AI output detector, with scores (higher meaning more likely to be generated) of median [interquartile range] of 99.98% [12.73, 99.98] compared with very low probability of AI-generated output in the original abstracts of 0.02% [0.02, 0.09]. The AUROC of the AI output detector was 0.94. Generated abstracts scored very high on originality using the plagiarism detector (100% [100, 100] originality). Generated abstracts had a similar patient cohort size as original abstracts, though the exact numbers were fabricated. When given a mixture of original and general abstracts, blinded human reviewers correctly identified 68% of generated abstracts as being generated by ChatGPT, but incorrectly identified 14% of original abstracts as being generated. Reviewers indicated that it was surprisingly difficult to differentiate between the two, but that the generated abstracts were vaguer and had a formulaic feel to the writing.

这里判断是99.98%是真人写的。

我们再检测一下上面用chatGPT生成的摘要

这里检测出了99.98%是假的,是由人工智能生成的。

总结

对于 ChatGPT 这类人工智能所可能带来的影响,我们其实不必过于担忧。尽管人工智能生成的内容可以被人工智能检测出来,但这并不意味着我们可以对此类技术放任不管。相反,我们需要更加重视这一问题,并采取相应的措施来应对。在未来,论文投稿过程中可能会出现新的挑战。除了需要进行传统的重复率检测之外,我们还需要加入 AI 痕迹检测。这样一来,我们就可以更有效地识别和防范 ChatGPT 等人工智能所可能带来的不良影响。总之,面对 ChatGPT 这类人工智能,我们不能掉以轻心。我们需要通过加强监管和采取有效措施,确保学术秩序不受干扰。同时,我们也需要积极探索新的解决方案,以应对这一领域的最新挑战。

我们

是Turnitin公司的官方合作伙伴,iThenticate查重系统官方授权查重机构。

我们是Turnitin的官方合作伙伴,论文直接上传至Turnitin服务器,保证您的论文安全。

iThenticate官方授权查重官网

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!