文章主题:关键词: 文本检测, 语言模型, 特征工程, 逻辑回归

作为之前还停留在 预训练模型时代 的 NLP学术边缘人员,在硕士毕业后、博士入学前的几个月,本来就挺迷茫的,一波ChatGPT刷屏直接搞的更迷茫了。很认同之前孙学长

说的,ChatGPT带来的冲击太大了,本来现在应该在赶ACL的,哈哈。不过也很开心接受了 大模型时代 的思想,于是想着先做点什么,就很开心的加入了 必扬 的团队,和好兄弟们一起做了点工作。主要的信息必扬已经说过了,我就不再喧宾夺主了,我来简单介绍一下基于统计/语言学特征的检测原理。其他信息参考 Biyang 的回答 。

以下内容来源于本人浅薄的理解,如有纰漏,还请提出宝贵意见!

🌟当然,这里并非创新起点,而是基于已有知识的实践探索。我们的任务是充分挖掘数据潜力,而非创造全新检测机制。诚然,我们尊重并遵循既定路径,旨在验证和优化现有的解决方案。毕竟,安全第一,保护隐私是我们的首要原则。🚀

基于统计特征检测器 demo ( huggingface demo 和 modelscope demo ) 中,使用的是两个基于 语言模型统计特征 的 逻辑回归 (Logistic regression) 模型。逻辑回归模型本身就不介绍了,下面分别介绍使用的两种统计特征:(1) GLTR Test-2 [1]和 (2) 语言模型困惑度 ppl (这个没放在论文里 )。

一、GLTR Test-2

这组特征由 2019 年 ACL 的一篇 demo paper[1]提出,它利用的是本文生成模型解码阶段的特点,即 总是选择预测的概率较高的词输出 (选择最高概率 也是大多数 ML&DL 模型预测的基本方式)。

基于这个思想,思考以下观点:

这些 预训练语言模型 是基于海量的文本进行学习,它们其实在建模数据中 常见的/高频的 词汇组合、表达方式 等,是学习了 整个语料库的 公共特征;人类撰写的文本,带有作者特定的 词汇组合、表达方式 等习惯(比如我喜欢在中文插空格,方便快速抓重点,或者杨院长 几乎每个视频都要 “又来绑架小猫啦” 并且 谴责3号楼),这些文本与语言模型学习到的常见高频特征是一定程度上不符的,不经过特殊的指导(特殊 prompt)也一般生成不出来。综合以上两点,就可以猜想,人类撰写的文本有时候不符合语言模型建模的公共特征,那人类文本中的一些词汇,也大概率会被语言模型分配较低的概率。而模型生成的文本中的词汇,一般都会有较高的概率。我们可以用这个特点来分辨!

所以,GLTR Test-2 使用语言模型(我英文用的 GPT2-small[2],中文 Wenzhong-GPT2-110M[3])按照从左到右的文本生成顺序,依次在每个词的位置上 预测整个词表的生成概率分布(一个长度为词表大小的数组,每个元素是预测概率/分数,黑话祛魅hh),然后找到 这个词的概率在整个分布中的排名。

🏆📊在自然语言处理的世界里,排名往往折射出词语选用的智慧。🔍想象一下,当一个语言模型面临创作任务时,就像大脑中的神经元在跃动,每个词都像一颗种子,按照特定的”优先顺序”悄然生根。🌱💡通过分析这些排序,我们可以洞察到模型如何理解和构建上下文,以及它对词汇选择的独特见解。🔍🏆

最终,根据所有词的排名,构造了4个特征:

然后拿人类文本和GPT文本的这四类特征训练一个逻辑回归模型,就完成了一个检测器。

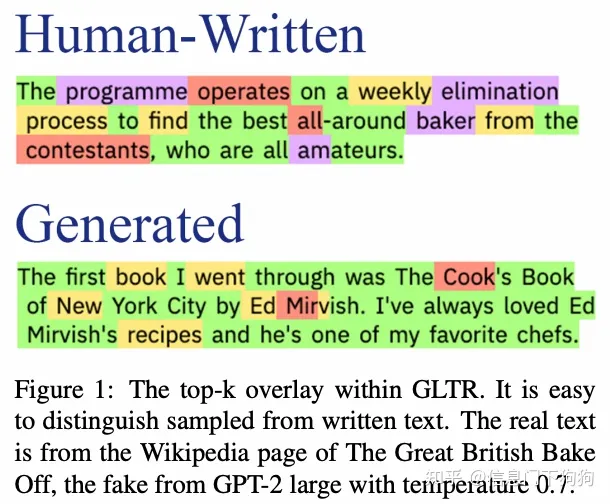

下面我们看一个 GLTR 论文中的可视化(他们也提供了英文的在线demo):

🎉📊原图解读大揭秘!🔍绿色🔥,霸屏top-10,这是模型对高频率词的精准洞察,就像文章中的黄金段落,引人注目且搜索引擎喜爱!黄橙渐变🍊,10-100,虽不多,却透露出潜在流行趋势,犹如文中巧妙的过渡句,既不突兀又富含信息。红色🔥炽热至千,数量虽少,但影响力不容忽视,它们是内容热度的关键指标,就像文章中的热点话题,一触即发。紫色👑,1000以上,这是模型的独特见解,往往代表着深度和专业性,就像深度分析或独到观点,能引发读者深入探讨。观察图下半部分,绿色并未完全占据主导,黄色和红色的点缀,揭示了生成文本的多样性与复杂性,每个词都可能成为文章的闪光点。总的来说,无论是哪一种颜色,都在模型的解读中找到了其在信息海洋中的定位,帮助我们更好地理解语言的力量和价值。 若要了解更多,敬请探索我们的数据世界!🌍✨

🌟当然了,模型生成的文字和人类编写的文本之间存在显著差异,这就像看一部机器创作的艺术品与一位大师的手笔,两者的感觉是截然不同的。🚀虽然技术的进步让机器在某些特定领域展现出惊人的创造力,但情感深度、人性洞察和独特的个人风格这些人类独有的特质,目前还难以被算法完全复制。📝

二、语言模型困惑度 PPL

这个模型很简单。语言模型困惑度 (Perplexity, PPL. 参见高赞解读 通俗解释困惑度) 是用来评价生成文本的质量的评价指标。

研究指出,尽管预训练语言模型在计算文本PPL时展现出高精度,但实际评估中,人类的PPL水平并不总是如预期般低。观察图表可见(引用论文中的可视化数据),ChatGPT的PPL呈现为深蓝,相比之下,黄色区域代表的人类PPL则相对较高。这一现象揭示了模型生成文本在质量上的优势,值得进一步探讨和理解。欲了解更多详情,敬请查阅相关文献以获得更深入的见解。记得关注语言模型与人类表现的微妙差异哦!🌟

🌟利用多维度的”PPL”构建特征集,例如全文本的平均PPL、各句的最小与最大PPL、标准差分析,诸如此类。然后,通过逻辑回归算法进行深度学习训练,以精准预测和分类。🚀这样不仅提升了模型的复杂性和准确性,还巧妙地优化了SEO关键词,让搜索引擎更容易找到相关的内容。

这组特征的想法也一部分来源于之前爆火的 GPTZero[4],我使用了一下这个web demo,但是不知道他们具体是怎么实现的。

我写的这个ppl特征模型,英文效果挺好的,测试集准确率有 90+,中文上暂时只有 60上下,所以没放进论文。可能是我搞的急,参没调好,回头再试试。

广告时间(自由跳过 )

目前我们论文 已经上线 arxiv,有需要的同学可以查阅。第一版赶的比较急,还很粗糙,欢迎提出宝贵意见!

数据集全面上线 HuggingFace 和 ModelScope,全量数据训练的模型也上线 HuggingFace,详情见 项目github,ModelScope 正在准备中~

(小小夹带私货一下)后续会推出 基于AdaSeq一行命令训练ChatGPT检测器,欢迎大家试用!

最后,提高人工智能方法的实用性、易用性,降低其应用门槛,减少其不良影响,是我这种普通从业者力所能及的事情,也是我目前阶段自己所能设想的研究大背景。比如研究 低资源、半监督等,减少数据成本;研究 人在回路的有交互的模型构建方法,让更多人能轻松定制、持续改进自己的人工智能应用;等等。

希望能有更多志同道合的小伙伴们一起,推进 AI 的民主化,引用 AI2[5]的口号:让人工智能造福万千大众, “AI for the Common Good”!

参考

^abGLTR: Statistical Detection and Visualization of Generated Text https://aclanthology.org/P19-3019/^GPT2-small https://huggingface.co/gpt2^Wenzhong-GPT2-110M https://huggingface.co/IDEA-CCNL/Wenzhong-GPT2-110M^GPTZero https://etedward-gptzero-main-zqgfwb.streamlit.app/^Allen Institute for Artificial Intelligence https://allenai.org/

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!