ChatGPT是一款人工智能聊天机器人,在2022年11月一经上线便引发关注。不同于以往广受诟病的“人工智障”,它能够深度理解上下文的关联,完成写文章、邮件甚至是敲代码的复杂任务。

在学术圈内掀起风浪,先后有学者拿它写论文摘要、改论文。

Nature为此专门颁布禁令:ChatGPT不能当论文作者。

Science则直接禁止投稿使用ChatGPT生成文本。

国内部分C刊也发表有关人工智能辅助论文写作的相关规定。

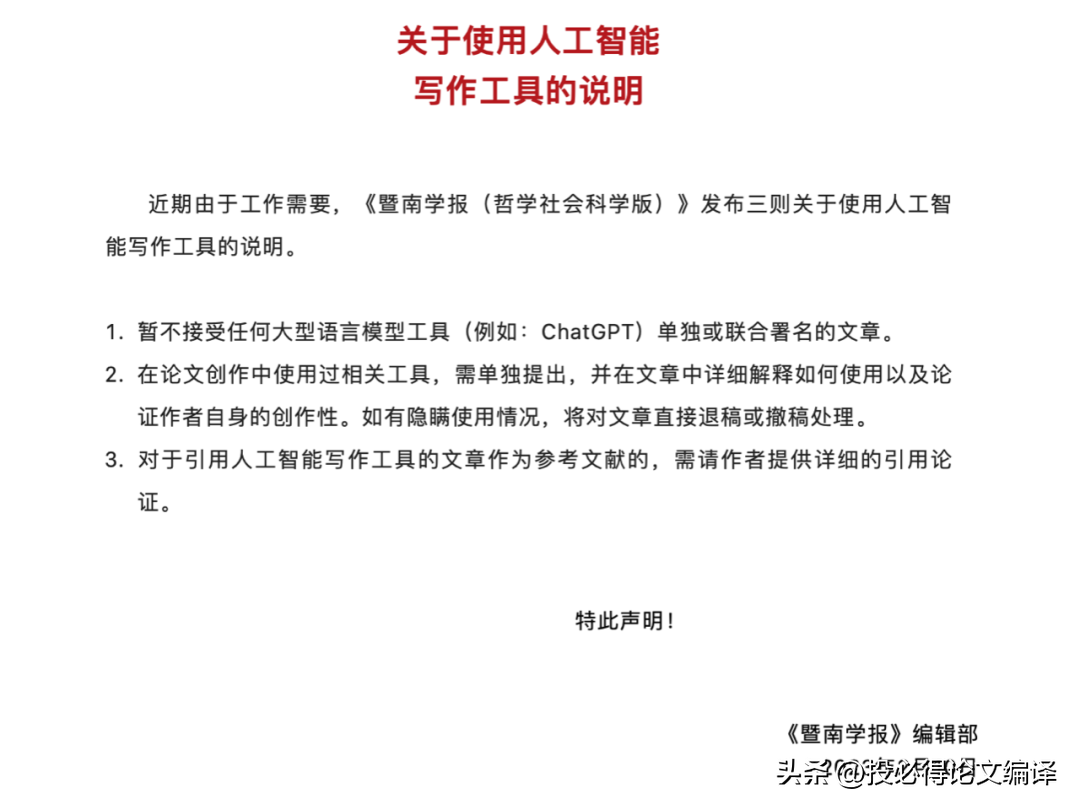

《暨南学报(哲学社会科学版)》官方公众号发布《关于使用人工智能写作工具的说明》译文。

《说明》中提到,暂不接受任何大型语言模型工具(例如:ChatGPT)单独或联合署名的文章。如果在论文创作中使用过相关工具,需单独提出,并在文章中详细解释如何使用以及论证作者自身的创作性。如有隐瞒使用情况,将对文章直接退稿或撤稿处理。对于引用人工智能写作工具的文章作为参考文献的,需请作者提供详细的引用论证。

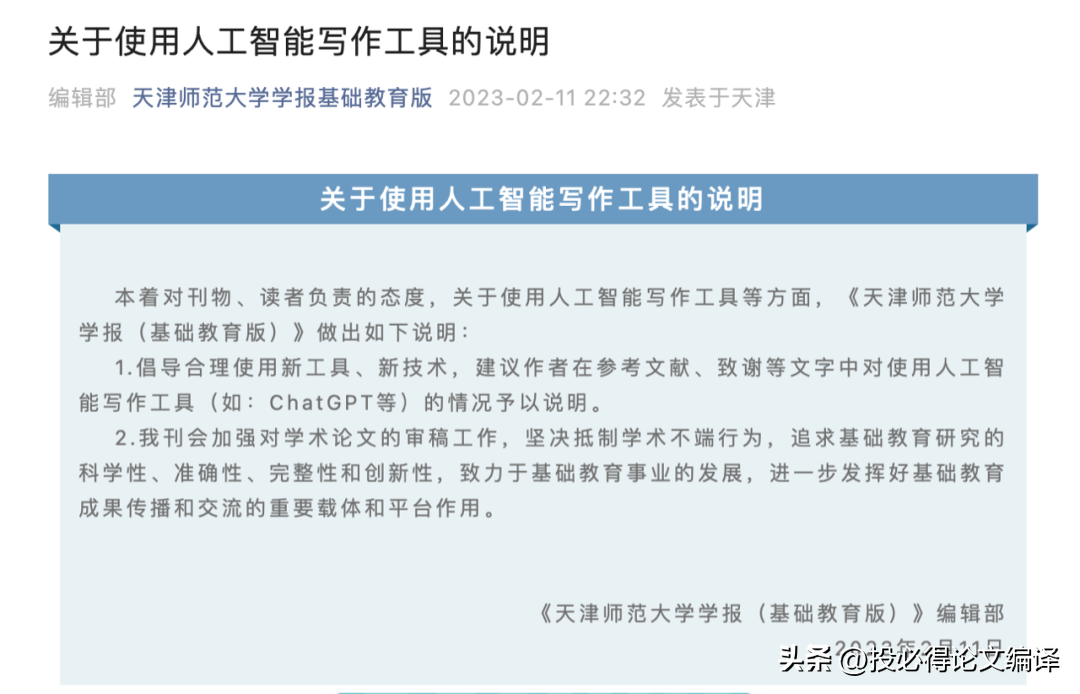

此外,天津师范大学学报基础教育版也发布相关声明,倡导合理使用新工具、新技术,建议作者在参考文献、致谢等文字中对使用人工智能写作工具(如:ChatGPT等)的情况予以说明。

但趋势已摆在眼前。

以ChatGPT为代表的通用型人工智能介入社会生活已成定局,将会不可避免出现在科研、写作、绘画等多领域。

直接关闭相关市场是最便捷、最自然的选择,但一味地严防死守、以事前禁止使用的方式规制ChatGPT将收效甚微。

采取这种方式,学术出版机构将面临建立有效的人工智能生成内容检测工具的压力。

现在更应该做的,或许是明确ChatGPT对于科学界的意义以及应当处于怎样的身位。

一周时间内,Nature连发两篇文章探讨ChatGPT及生成式AI。

在《ChatGPT:五大优先研究问题》一文中,研究人员提出:

无法阻止ChatGPT杀入学术圈,当务之急应该是研究探讨它会带来哪些潜在影响。

如果后续ChatGPT被拿来设计实验、进行同行审议、辅助出版、帮编辑决定是否要接收文章……这些应用应该注意哪些问题?现在人类需要明确哪些边界?

研究人员认为,有5个方面需要优先考虑,并解释了原因。

(1)坚持人工验证

ChatGPT等对话式AI的一大特点,就是回答内容的准确性无法保证,而且编出来的瞎话都还很自然,容易对人产生误导。

研究人员认为如果有学者使用了ChatGPT帮忙做研究,很可能错误或有偏见的信息所误导,并将其纳入他们的思维和论文中。而且,由于这种技术通常是在没有可靠地引用原始来源或作者的情况下复制文本,使用这种技术的研究人员有可能不知不觉地剽窃了许多未知的文本,甚至可能泄露了自己的想法。研究人员向ChatGPT和其他LLM透露的信息可能会被纳入模型,聊天机器人可以将其提供给其他人,而不承认原始来源。

专家驱动的事实检查和验证过程将是不可或缺的。高质量的期刊可能需要加入人工验证步骤,甚至禁止某些使用这种技术的应用。研究人员认为,人类应该始终对科学实践负责。

(2)制定问责规则

为了应对生成式AI的滥用,很多鉴别AI文本工具陆续诞生,它们能很好分辨出一段文字是不是人类自己写的。

不过,研究人员认为这种“军备赛”大可不必,真正要做的是让学术圈、出版商能更加公开透明地使用AI工具。

论文作者应该明确标注哪些工作是AI承担的,期刊如果使用AI审稿,也应该公开说明。

在未来,LLM可能会被纳入文本处理和编辑工具、搜索引擎和编程工具。因此,它们可能会对科学工作做出贡献,而作者不一定知道其贡献的性质或程度。这违背了今天对作者身份、剽窃和来源的二元定义,即某人要么是作者,要么不是,来源要么被使用,要么没有。

由人工智能设计的发明已经引起了对专利法的根本性反思。

在人工智能写作的或辅助的手稿的情况下,研究和法律界也需要弄清楚谁拥有这些文本的权利。是写人工智能系统训练的文本的个人,还是生产人工智能的公司,或者是使用该系统来指导他们写作的科学家?

(3)投资真正开放的LLM

目前,几乎所有先进的对话式AI,都是科技巨头们带来的。这也引发了社会各界的道德担忧,因为巨头们的垄断行为,严重违背了科学界开放的原则。

对研究界来说,最直接的问题之一是缺乏透明度。ChatGPT及其前身的基础训练集和LLMs是不公开的,科技公司可能会隐瞒其对话式人工智能的内部运作。这与透明度和开放科学的趋势背道而驰,也使我们很难发现聊天机器人知识的起源或差距。

(4)拥抱AI的优点

虽然有很多方面需要设限,但不可否认,AI确实能提升学术圈的效率。

比如一些审查工作,AI可以快速搞定,而学者们就能更加专注于实验本身了,成果也能更快发表,从而推动整个学术圈的脚步走得更快。

甚至在一些创造性工作上,研究人员认为AI也能有用武之地。

1991年的一篇开创性论文提出,人和AI之间形成的“智能伙伴关系”,可以胜过单独人类的智力和能力。

这种关系能够将创新加速到无法想象的水平。但问题是,这种自动化能走多远?应该走多远?

因此,研究人员也呼吁,包括伦理学家在内的学者,必须就当今AI在知识内容生成方面的界限展开讨论,人类的创造力和原创性可能仍旧是进行创新研究必不可缺的因素。

(5)扩大讨论范围

鉴于当下LLM带来的影响,研究人员认为学界应该紧急组织一场紧急而广泛的讨论。

他们呼吁,每个研究小组都应该立即开组会,讨论并亲自试试ChatGPT。大学老师应该主动和学生讨论ChatGPT的使用和伦理问题。

在早期规则还没有明确的阶段,对于研究小组负责人来说,重要的是如何号召大家更公开透明地使用ChatGPT,并开始形成一些规则。以及应该提醒所有研究人员,要对自己的工作负责,无论它是否由ChatGPT生成。

更进一步,研究人员认为要立即举办一个国际论坛,讨论LLM的研究和使用问题。

成员应该包括各个领域的科学家、科技公司、研究机构投资方、科学院、出版商、非政府组织以及法律和隐私方面的专家。

ChatGPT对科学意味着什么?

兴奋又担忧,大概是许多研究人员对于ChatGPT的感受。

发展到现在,ChatGPT已经成为了许多学者的数字助手。

计算生物学家Casey Greene等人,用ChatGPT来修改论文。5分钟,AI就能审查完一份手稿,甚至连参考文献部分的问题也能发现。至于费用也很低,一篇论文只要0.50美元不到。

来自冰岛的学者Hafsteinn Einarsson,几乎每天都在用ChatGPT来帮他做PPT、检查学生作业。

还有神经生物学家 Almira Osmanovic Thunström觉得,语言大模型可以被用来帮学者们写经费申请,科学家们能节省更多时间出来。

不过,Nature对ChatGPT输出内容做出了精辟总结:流畅但不准确。

要知道,ChatGPT的一大缺点,就是它生成的内容不一定是真实准确的,这会影响它在学术圈的使用效果。

这能解决吗?

从现在来看,答案有点扑朔迷离。

但无论如何,ChatGPT及生成式AI,开启了人类新的一扇想象之门。

医学学者埃里克·托普(Eric Topol)表示,他希望未来能有包含LLM的人工智能,可以交叉检查学术文献中的文本和图像,从而帮助人类诊断癌症、理解疾病。这一切都需要专业人士的监督。

研究人员如何使用这些工具不仅决定了它们的未来,也决定了人类的未来。“要说2023年初,一切已尘埃落定,是不现实,”Topol说,“现在才刚刚开始。”

参考链接:

[1]https://www.nature.com/articles/d41586-023-00340-6

[2]https://www.nature.com/articles/d41586-023-00288-7

请提供文章内容,我才能提取关键词。