文章主题:ChatGPT, 用法, 多样化, 检测器

ChatGPT火了以后,用法是真多。

有人拿来寻求人生建议,有人干脆当搜索引擎用,还有人拿来写论文。

论文…可不兴写啊。

美国的一些大学已经明确禁止学生使用ChatGPT来完成作业,并且他们在努力开发各种软件工具,以便能够辨别学生提交的论文是否由人工智能系统生成。

这里就出了个问题。

有人论文本来就写的烂,判断文本的AI以为是同行写的。

更搞的是,中国人写的英文论文被AI判断为AI生成的概率高达61%。

这….这这什么意思?气抖冷!

非母语者不配?

目前,生成式语言模型发展迅速,确实给数字通信带来了巨大进步。

但滥用真的不少。

在当前的科技环境中,人工智能与人类生成的内容日益增多,这使得如何准确地区分两者变得越来越重要。尽管已有多种检测方法被提出,但它们在公平性和稳定性方面的不足仍然成为一个亟待解决的问题。为了确保这些方法能够可靠地分辨出AI生成的内容,研究人员需要不断努力改进和完善它们。

为此,研究人员使用母语为英语和母语不为英语的作者写的东西评估了几个广泛使用的GPT检测器的性能。

根据研究发现,这些检测器错误地将非母语者的写作样本误认为是AI生成的,而对于母语写作样本,其识别准确性却相当高。

此外,研究人员还证明了,用一些简单的策略就可以减轻这种偏见,还能有效地绕过GPT检测器。

这说明什么?这说明GPT检测器就看不上语言表达水平不咋地的作者,多叫人生气。

让我想起那个让人思考AI与真实之间的游戏的例子。在该游戏中,你对面的玩家可能是AI,而你却误以为他们是真实存在的人。这时,系统会提示你:“对方可能会觉得你冒犯了。”这种场景让我想起了人类在交流中可能出现的误解和冲突,同时也揭示了AI在模拟人类行为时的局限性。

不够复杂=AI生成?

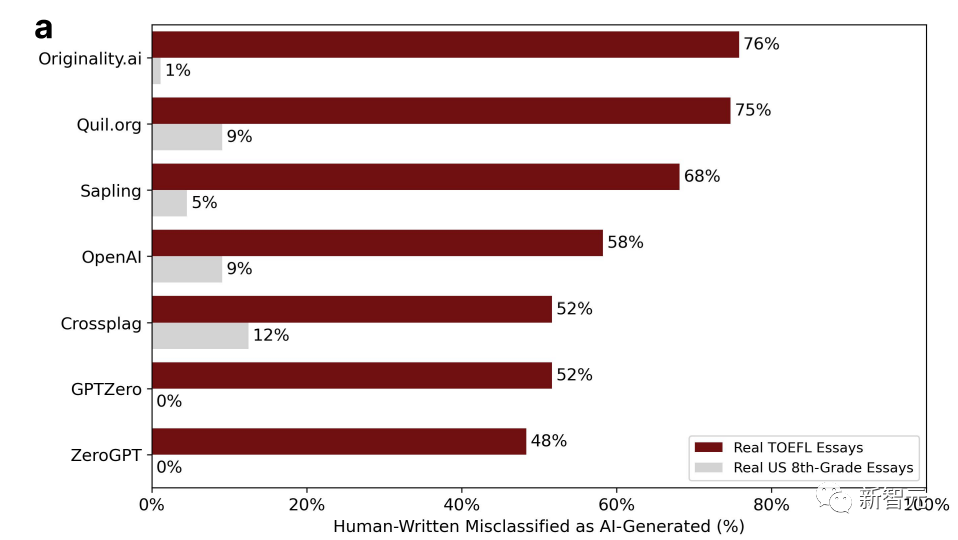

在深入研究英语作为国际通用语言的过程中,研究人员从我国的教育论坛中搜集了91篇托福作文,并从美国Hewlett基金会的数据集中选取了88篇由八年级学生撰写的作文,旨在检测7个广泛应用的GPT检测器在其中的表现。

图表中的百分比表示「误判」的比例。即,是由人写的,但检测软件认为是AI生成的。

可以看到数据非常悬殊。

七个检测器中,美国八年级学生写的作文被误判的概率最高才12%,还有两个零误判的GPT。

中国论坛上的托福作文被误判的概率基本全部过半,最高误判概率可达76%。

在91篇托福作文中,有18篇被全部7个GPT检测器一致认定为人工智能生成。然而,在91篇作文中,有89篇都至少被一个GPT检测器错误地判断为AI创作。

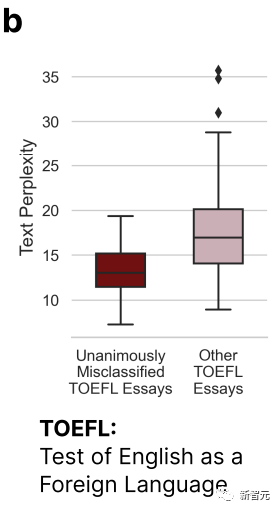

从上图中可以明显观察到,那些被七个GPT共同误判的托福作文在复杂度(Complexity)方面显然低于其他论文。

这就印证了开头的那个结论——GPT检测器会对那些语言表达能力有限的作者有一定偏见。

因此,研究人员认为,GPT检测器应该多看点儿非母语者写的文章,样本多了,才能消除偏见。

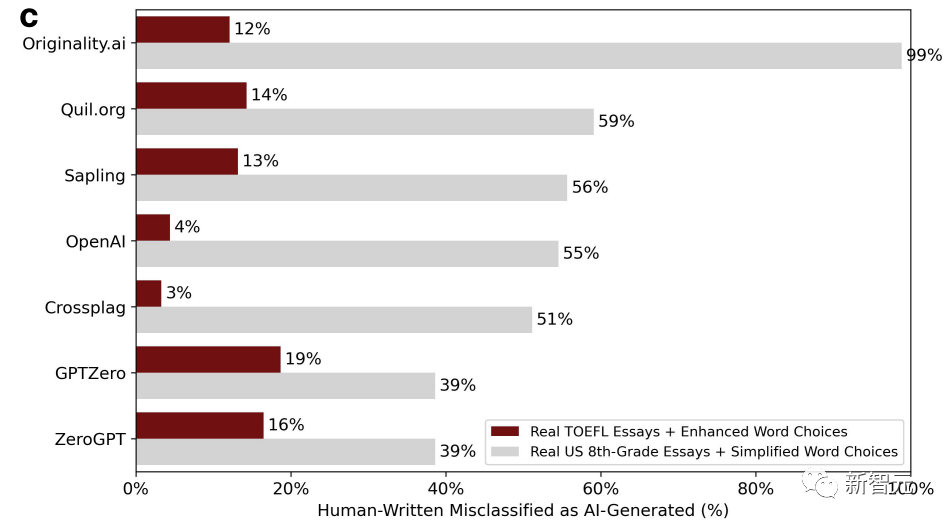

接下来,研究人员把非母语者写的托福作文扔到了ChatGPT里,丰富一下语言,模仿母语者的用词习惯。

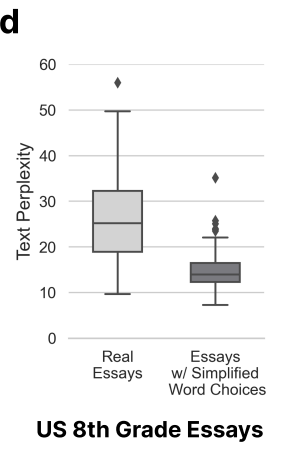

在本次实验中,我们采用了对照组的方式,将美国八年级学生的作文纳入其中,并对这些作文进行了简化,模仿非母语者的写作风格。经过处理后,我们发现这些修改后的作文在某种程度上与原始文本有所差异。下圖展示了修正後的新判定結果。

我们可以发现,情况来了个大掉个儿,丰富了语言的托福作文错判率直线下降,低至3%,最高也不过19%。不像之前基本全部过半的错判率。

与之相反,八年级小孩儿写的作文的错判率直线上升,甚至还有一个GPT检测器的错判率高达99%,基本全错。

因为,文章复杂度这个变量出现了变化。

这里研究人员就得出了一个结论,非母语者写的东西不地道,复杂度低,容易被错判。

这也就导向了一个技术问题,同时也是一个价值问题。以复杂度来判定AI还是人类是作者,是否合理、全面、严谨。

结果显然不是。

以复杂度为判断标准的情况下,非母语者吃了大亏,因为,他们是非母语者(废话)。

AI润色=人类写的??

研究者认为,加强语言多样性不仅可以减轻对非母语者的偏见,还能让GPT生成的内容绕过GPT检测器。

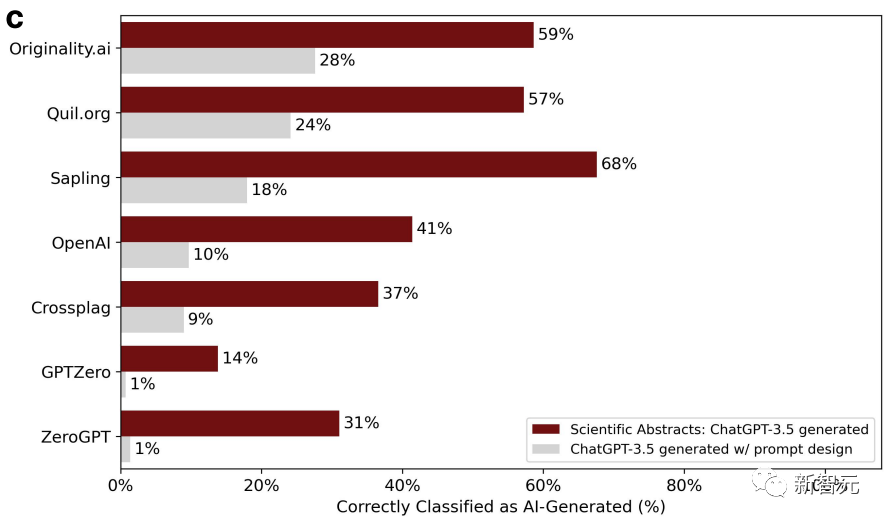

为了证明这个观点,研究人员选取了2022-2023年间美国大学申请的入学论文题目,输入到ChatGPT-3.5里,一共生成了31篇假论文。

GPT检测器一开始还挺有效,但是第二轮就不行了。这是因为,在第二轮中,研究人员把这些论文又扔到ChatGPT里润色了一下,用一些文学性的语言提升了文本质量。

这样一来,GPT检测器的准确度就从100%直降到了0%。如下图:

经过润色的文章复杂度相应也上升了。

与此同时,研究人员又用了斯坦福大学145个期末项目报告的题目,让ChatGPT生成摘要。

摘要经过润色以后,检测器判断的准确性继续下降。

研究者再次得出结论,润色过的文章很容易被误判,都是AI生成的,两轮就是比一轮强。

GPT检测器?还是欠练

言而总之,总而言之,各种GPT检测器好像还是没能抓住AI生成和人类写作之间最本质的区别。

人的写作也分三六九等,仅靠复杂度判断,不甚合理。

抛开偏见因素不谈,技术本身也亟待改进。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!