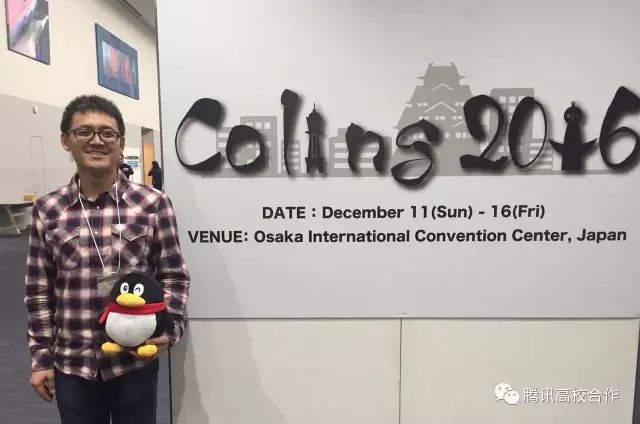

文章主题:日本, 大阪, 国际计算语言学会议, COLING-2016

COLING 2016

日本·大阪 12.11-12.16

国际计算语言学会议(COLING)是日本大阪举办的一年一度的自然语言处理与计算语言学领域的顶级学术盛宴,第26届 COLING-2016 将于12月11日至12月16日盛大启幕。作为该领域的权威会议,COLING 为学者们提供了一个交流、探讨和分享计算语言学最新研究成果的绝佳平台。

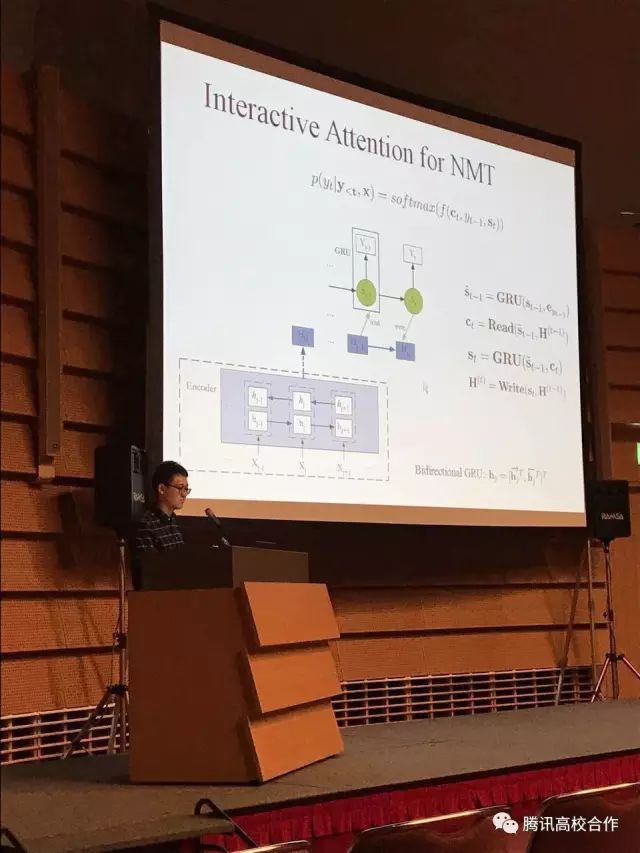

腾讯AI平台孟凡东博士报告独家报道

在本次会议中,共有1039篇有效投稿,其中337篇论文脱颖而出并被录用,接收率为32%。这些论文的呈现形式多样,包括Oral和Poster两种。值得注意的是,有135篇论文以Oral报告的形式被录取,占总数的近13%,显示出该会议对于高质量研究成果的高度认可。值得一提的是,腾讯AI平台的孟凡东博士带来了一篇名为《Interactive Attention for Neural Machine Translation》的精彩论文。这篇论文以其独特的视角和深入的研究成果,成功获得了会议的Oral报告机会。该报告将于12月15日下午17点30分在大阪国际会议中心的Conference Hall举行。整个报告过程预计将持续约30分钟。届时,相信会有众多学者聚集一堂,共同探讨这一前沿课题,现场气氛也将十分热烈。

报告概要

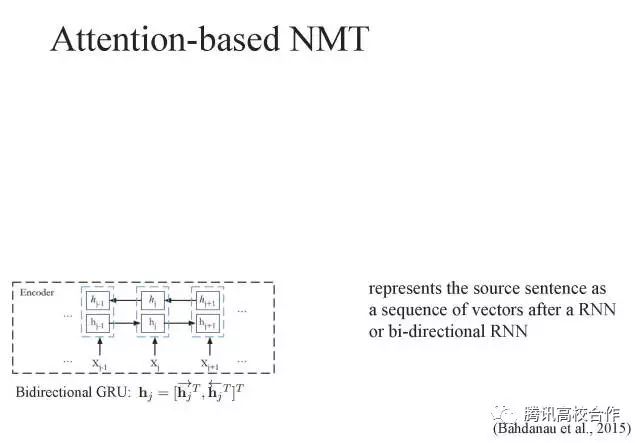

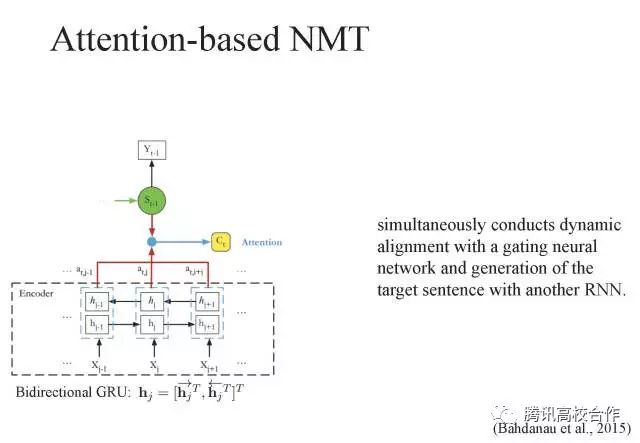

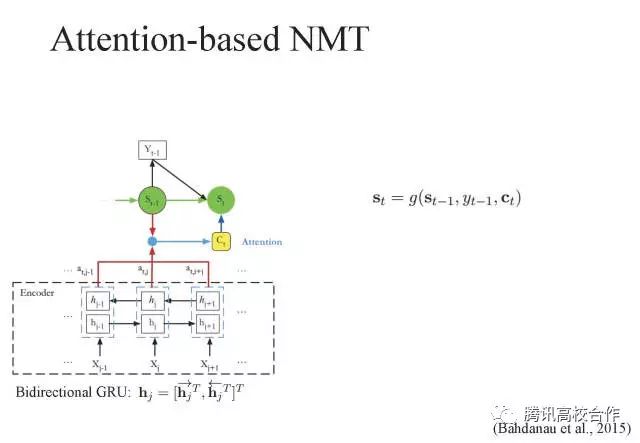

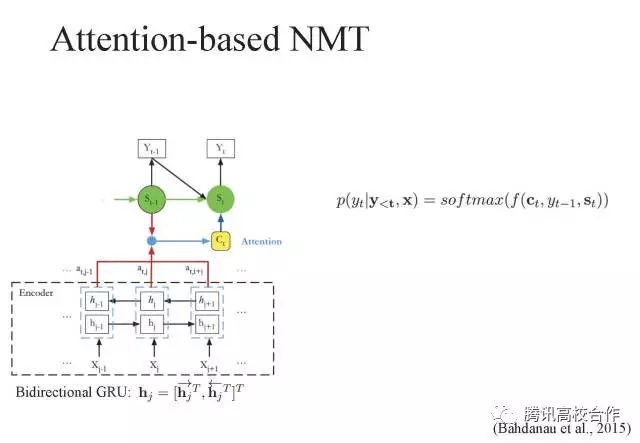

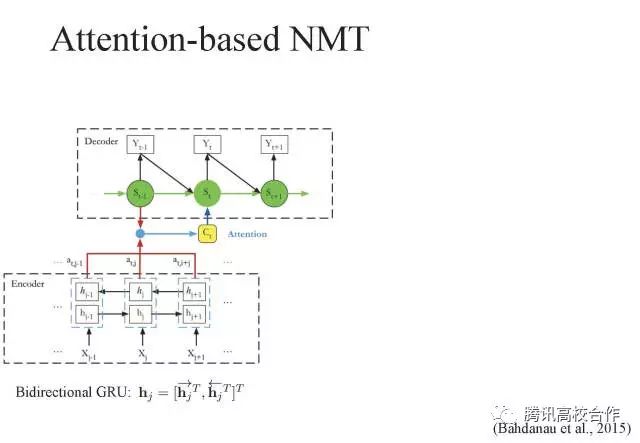

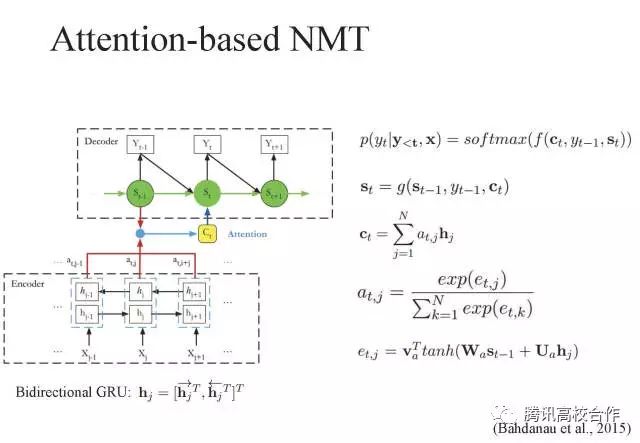

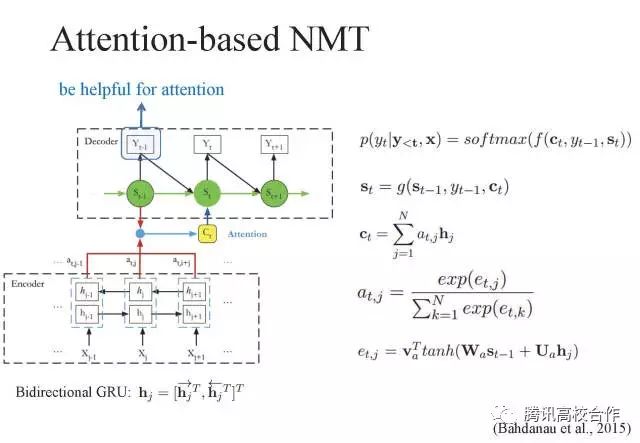

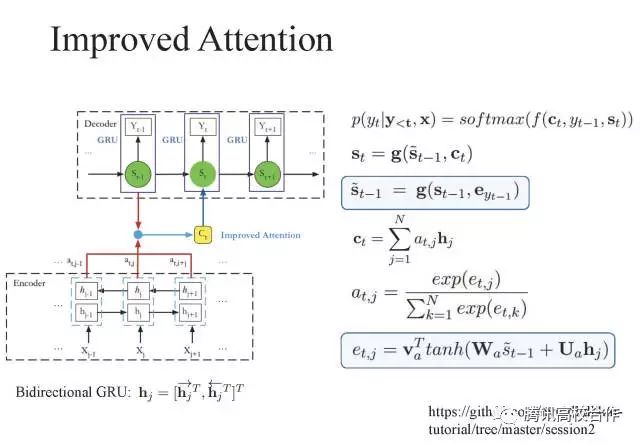

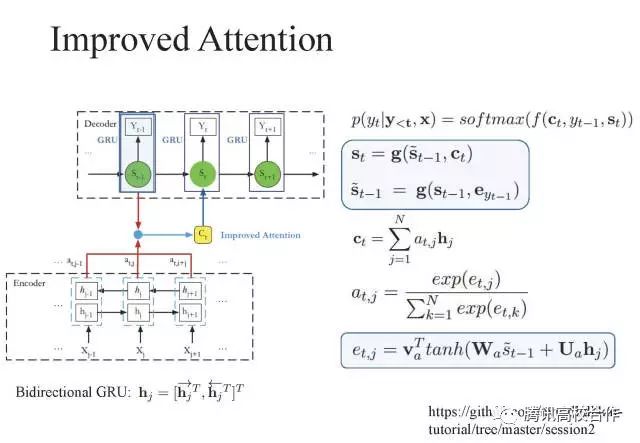

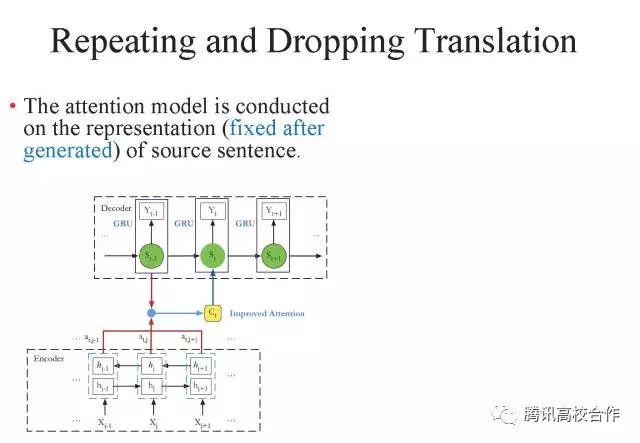

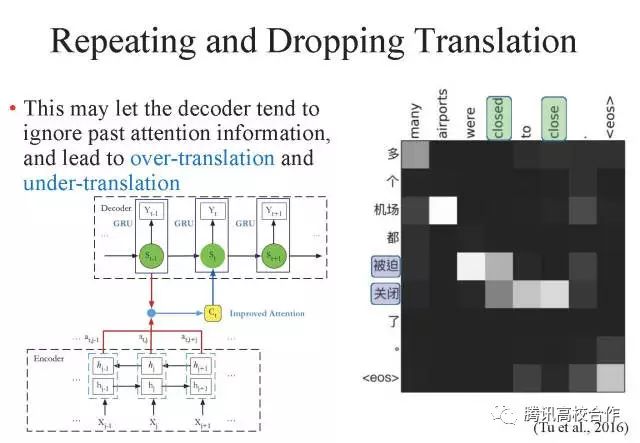

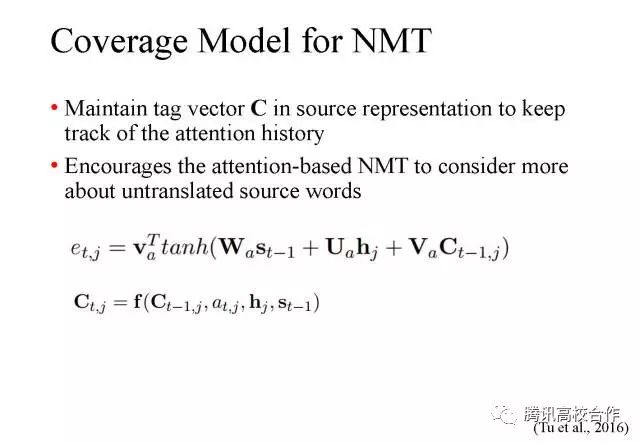

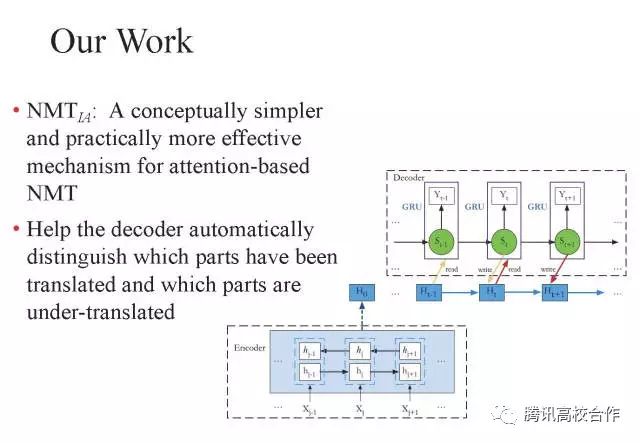

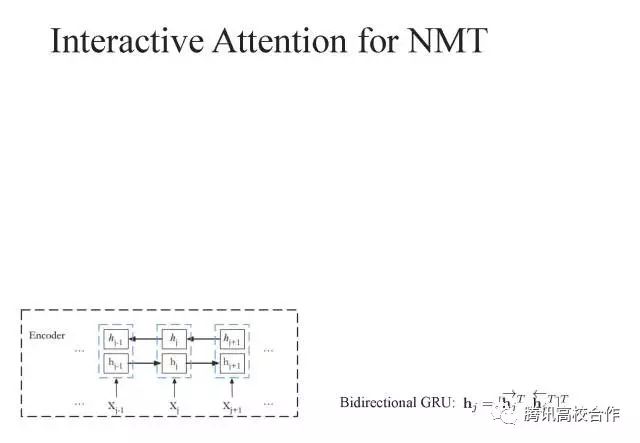

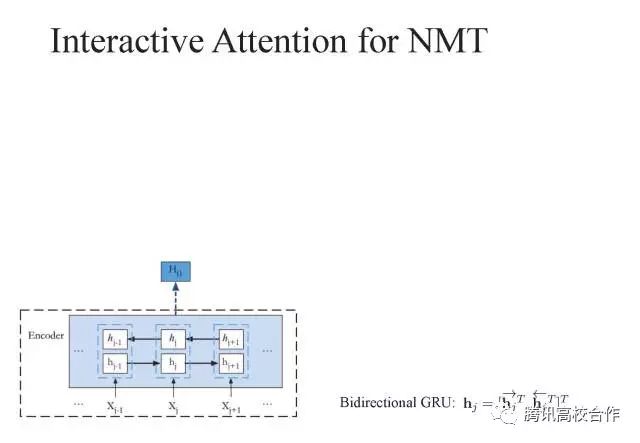

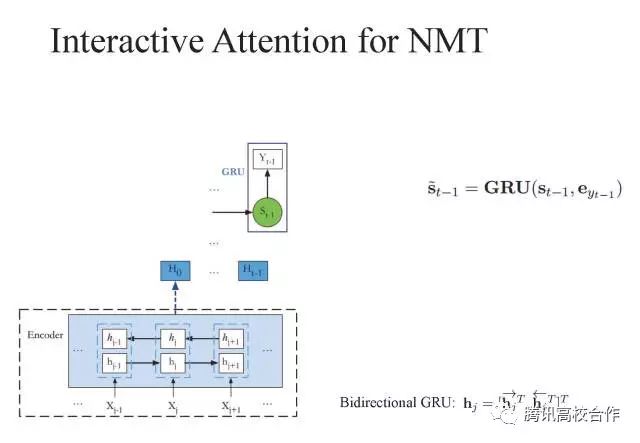

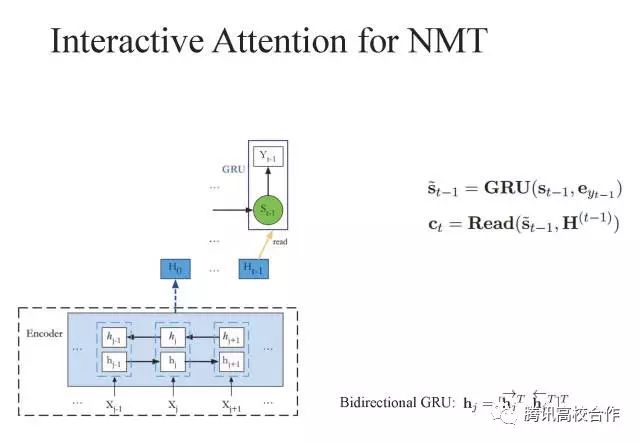

在论文《Interactive Attention for Neural Machine Translation》中,作者提出了一种全新的交互式注意力模型,旨在解决神经机器翻译中普遍存在的漏翻译和重复翻译问题。实验数据显示,该模型在多个中英翻译测试集上,均取得了显著的成果,其BLEU值大幅度提高。目前,基于注意力模型的神经机器翻译是学术界和工业界的研究重点。然而,传统的基于注意力模型的神经机器翻译尚无有效手段保证翻译的完整性,导致翻译结果出现漏翻译和重复翻译的问题。针对这一问题,一些学者从翻译覆盖的角度出发,构建了一些改进的注意力模型。而本文则另辟蹊径,从Memory读写的角度出发,借鉴神经图灵机的思想,提出了一种新的交互式注意力模型。交互式注意力模型的独特之处在于,在翻译过程的进行中,它可以根据当前的翻译状态动态地调整源语言句子的表示。这意味着在每一步的翻译过程中,翻译解码器所看到的源语言句子表示都是不同的,这与传统注意力模型中源语言句子表示一旦编码器处理完毕就无法再改变的情况有本质区别。这种对Memory的读写机制,让翻译解码器能够根据已翻译的状态,灵活地调整源语言句子的表示,从而更容易记住翻译过程中的注意力历史。这有助于解码器更准确地判断源语言句子哪些部分尚未翻译,哪些部分已经过翻译,进而有效地缓解漏翻译和重复翻译的问题,进一步提升翻译的效果。

更多AI领域国际会议快讯,随时follow我们哟!

明年见!

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号AIGC666aigc999或上边扫码,即可拥有个人AI助手!