文章主题:铜灵, 凹非寺, AI论文, 摘要

铜灵 发自 凹非寺

量子位 出品 | 公众号 QbitAI这一次AI自己给AI论文生成了一次摘要。

今天,一个可为长文自动生成总结的Transformer语言模型论文在推特火了起来。

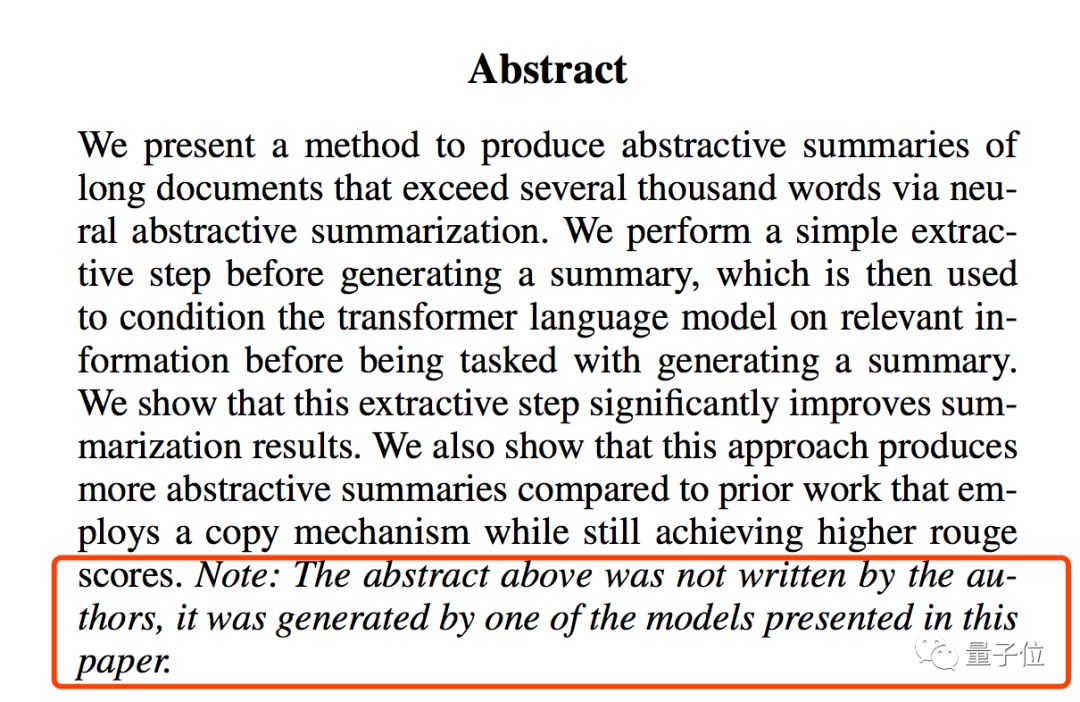

在仔细阅读论文摘要的结尾部分时,网友们意外地发现了一个斜体注释:上述摘要并非出自作者之手,而是由研究过程中所采用的一个模型自动生成的。

以假乱真的生成质量,让不少网友大吃一惊。并且,其生成方式也不一般:

经过大量研究证实,即使缺乏复制机制,Transformer语言模型在处理长篇科学文章方面依然具有显著优势,其表现甚至超过了传统seq2seq方法。

此外,相较于之前采用复制策略的研究,本方法生成的摘要更为全面。在衡量自动生成的摘要及翻译水平的ROUGE评估中,该方法取得了更高的评分。

经过OpenAI研究科学家、牛津大学人类未来研究所研究员Miles Brundage的力挺与广泛传播,该项研究在短短不到一天时间内便获得了近2000个点赞,引来了广大网友的关注。甚至有人将其形容为一场“摘要图灵测试”,足见其在网络上的热度之高。

还有网友表示,在未来十年内,我们或许能看到第一篇transformer写出的研究论文了。

所以,这个让网友大吃一惊的总结摘要生成模型,到底是如何以假乱真的?

请看摘要↓

非复制机制

我们提出了一种新的方法,通过神经摘要式总结,可以为篇幅超过上千字的长文档自动生成摘要。我们展示了一种在生成总结前的简单提取步骤,在执行生成摘要任务前,会根据相关信息,将其用于Transformer语言模型,帮助模型进行条件设置。实验结果表明,这个步骤显著提高了总体结果。我们还证明了,与之前使用复制机制(copy mechanism)的工作相比,这种方法生成了抽象的总结,并且还能取得更高的Rouge分数。在过去,摘要提取技术主要依赖序列到序列(seq2seq)学习方法,其中关键词的识别被理解为生成问题,而在输出过程中,关键短语被视为词序列。

为了确保控制参数的数量仅选择出现频率较高的词汇,那些相对低频但重要性更高的词汇在提取过程中容易被忽略。为了解决这一问题,我们提出了“复制机制”,从而在提取过程中确保这些重要词汇得到充分考虑。

通过复制机制,模型解码器的部分隐藏状态当成特定的位置,不通过生成过程定义关键词,而是直接复制。

这样一来,就能保留原始文章中的重要信息了,进而在输出端生成出摘要。

而在这篇论文中提到,不通过复制机制也可以准确提取重点信息。这是怎么做到的?

Transformer语言模型

在论文《On Extractive and Abstractive Neural Document Summarization with Transformer Language Models》中,研究人员详细阐述了模型的构建过程。

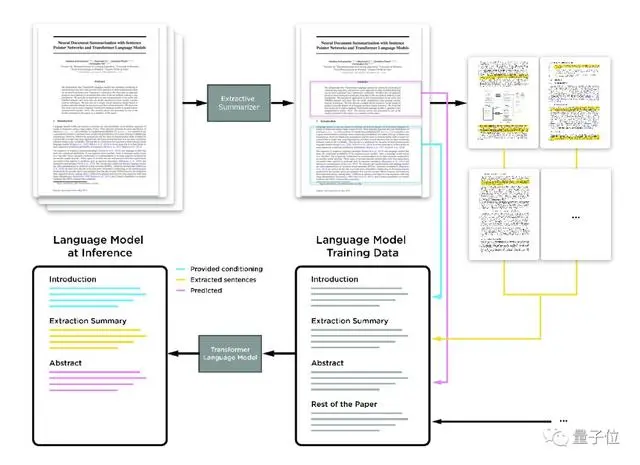

这个模型提取科学论文的摘要是分阶段的。

首先,句子指针网络(pointer network)从论文中提取出重要信息。

在接下来的步骤中,我们会将这些提取出来的句子与完整的文章按顺序整合在一起:首先是引言部分,紧接着是所抽取的句子,随后是摘要,最后是论文的其他内容。这种特定的组织方式就是Transformer语言模型在训练过程中所采用的格式。

在推理运算中,引言与提取的句子将作为背景信息被提供给语言模型,并最终生成摘要。在新闻报道和专利申请的领域中,引言部分将会被全面取代。

与此前大多数神经抽象概括方法不同,这种方法没有使用带有显式编码器和解码器的seq2seq公式来生成单词。

具体来说,研究人员使用单个类似GPT的Transformer 语言模型(TLM)进行训练,在推理阶段根据文档从语言模型中生成摘要。

研究人员将这个任务一分为二,即提取步骤(extractive step)和抽象步骤。

为了处理超过几千个单词的超长文档,他们先使用两个不同的分层文档模型对句子进行提取,一个基于指针网络,另一个基于句子分类器,这样的结构保证在生成摘要前更好地调整Transformer语言模型的相关信息。

研究人员选取了四种不同的大型长文档摘要数据集,分别为arXiv、PubMed 、bigPatent和Newsroom,对模型进行测试,并用Rouge指标进行测试。

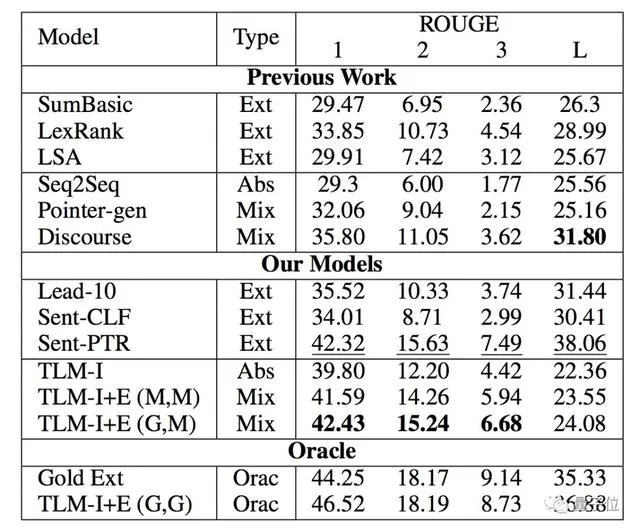

无论是针对arXiv上的科学论文:

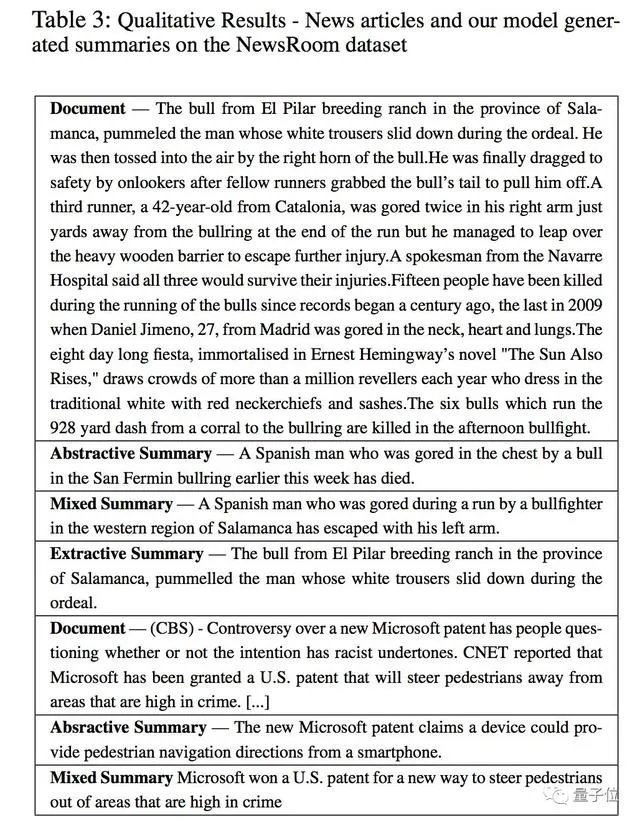

还是NewsRoom上的新闻:

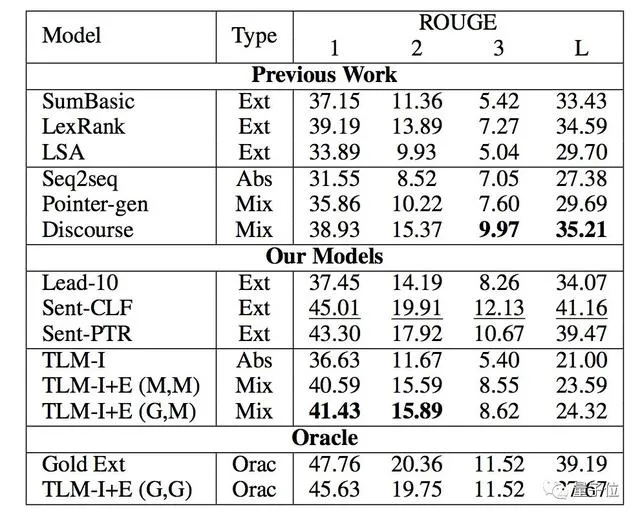

甚至是PubMed上的生物医学方面的论文:

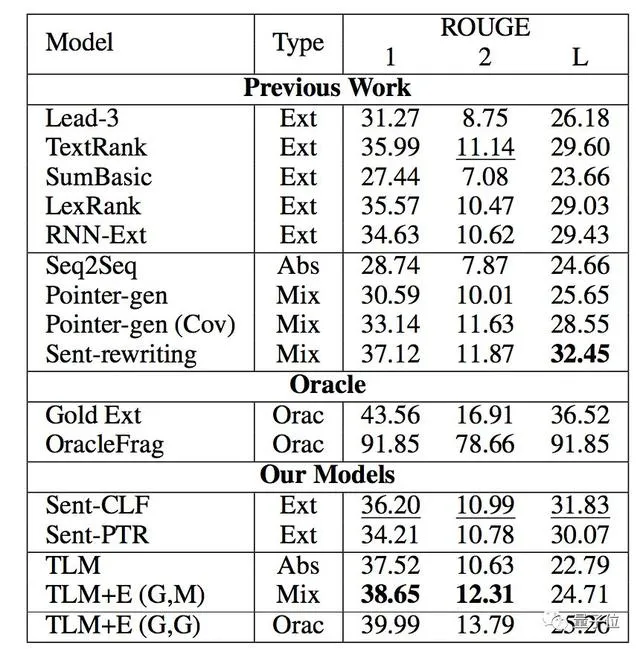

还是130万份美国专利文献记录bigPatent :

新方法TLM均优于此前摘要提取的baseline,并超越了先前提取结果。

作者介绍

这篇论文的共同一作共有三位,均来自Element AI。

包括蒙特利尔学习算法研究所的Sandeep Subramanian,Raymond Li和蒙特利尔大学的Jonathan Pilault及Christopher Pal。

Element AI想必大家不会陌生,这是图灵奖得主、蒙特利尔大学计算机系教授Yoshua Bengio创办的创业孵化器,帮助来自蒙特利尔大学和McGill大学的AI创业者施展拳脚。

传送门

On Extractive and Abstractive Neural Document Summarization with Transformer Language Models

— 完 —

量子位 · QbitAI

վᴗ ի 追踪AI技术和产品新动态

戳右上角「+关注」获取最新资讯↗↗

如果喜欢,请分享or点赞吧~比心❤

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!