ChatGPT越来越“有人味”,人类该何去何从?听听大咖们怎么说

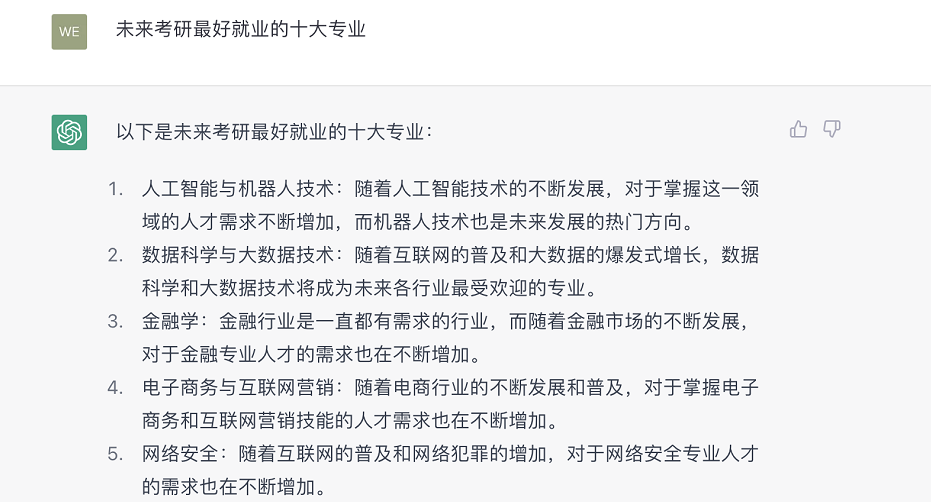

最近,许多人都多了一位“网友”——ChatGPT。 它是一个聊天机器人,由美国人工智能公司OpenAI推出,从2022年12月1日正式发布至今,月活跃用户已达1亿,成为历史上增长最快的消费者应用程序。 说是聊天机器人,它可不只能“唠嗑”。大数据、大算力、强算法赋予了它“超级大脑”。它能写作业、写论文、当助教,写代码更是“老本行”,能通过工程师测试、硕士期末考试,俨然一个“全能学霸”。 强化学习、交互训练又让它学会“说人话”。它也能创作文案、小说、剧本,比起它的AI前辈们,改掉了很多“机器腔”。 但毫不例外,ChatGPT也有站在阴影里的另一面。偏见无法避免,成本依旧高昂,推理能力不足,甚至会“一本正经地胡说八道”。还有不少用户吐槽,ChatGPT给出的参考建议笼统模糊、过于四平八稳,缺乏信息密度,常有“正确的废话”。 ChatGPT究竟是不是钻进人类社会的一条鲶鱼? ChatGPT是否宣告“强人工智能”时代的到来? ChatGPT如何影响人类的未来,它自身的未来又会迈向何方? 当AI越来越强大甚至无限趋近于人,甚至超越于人,那么属于人的,还有哪些抢不走的领地和独特的价值? 近日,新华社中国搜索团队召集业界权威专家,剖析前沿,华山论剑,透视“风口”,把脉AI的发展。 来源:2月17日《新华每日电讯》 整理:新华每日电讯记者王若辰 ■访谈嘉宾 王金桥:中国科学院自动化研究所研究员 唐 明:中国科学院自动化研究所研究员 陈雨强:第四范式首席科学家、联合创始人 季逸超:第四范式科学家 沈 阳:清华大学新闻学院教授 高 跃:清华大学软件学院副教授 车万翔:哈尔滨工业大学计算机学院教授 凌 强:中国科学技术大学自动化系教授 杨 君:清华大学自动化系副研究员 吴 楠:南京大学计算机系副教授 何俊良:上海交通大学计算机系助理教授 漫画 曹一“强人工智能”时代就此到来? 王金桥:ChatGPT基本上把2021年及以前互联网上所有的数据都学习了一遍,相当于一个世界知识的统一建模。在如此规模的参数量下,更好的关联推理就能够实现了,也能够通过算法更好地模拟人的意图。所以业内很多人认为ChatGPT是人工智能的再一次革命性突破。 但也有人不认可,认为ChatGPT还只是世界知识的一个组合,基于组合产生了一些观点和判断。 我认为ChatGPT现在的问题,一是对常识的建模弱了点,很多网友晒出了ChatGPT“翻车”、令人啼笑皆非的回答;二是缺乏多模态的信息,目前它的推理较弱,理解不了诸如“说曹操曹操到,到底是小明到了还是曹操到了”这样的信息。 车万翔:回顾自然语言处理发展史,可以发现一个有趣现象:20世纪50年代,自然语言处理初代范式诞生,主要是做专家知识系统,或用小规模的规则系统实现机器自处理,这一阶段持续了约40年;之后进入浅层机器学习算法阶段,持续了约20年;2010年后开启了深度学习算法时代,直到2018年第一代GPT等的面世,又带我们走进大规模预训练模型的时代;4年后,正是2022年末,ChatGPT引爆全球关注——每一代突破性技术诞生的间隔,都差不多是上一代的一半。按“摩尔定律”继续推演,我们可以憧憬,到2025年可能会有新的、更强大的AI诞生。 凌强:ChatGPT比我想象得要好。在我的想象中,ChatGPT可能会给我“和稀泥”的回答,相当于没有对也没有错,但实际上它给我的答案还是有针对性的,从AI技术的角度讲,ChatGPT在特征工程上应该有非常强大的方案。 另外,当我用同一问题反复问它,它的回答并非千篇一律,而是具有一定的差异性。这也让它更像“人”,毕竟问一个人想吃什么,他每次会有不同的回答,这说明ChatGPT的随机决策模型也做得不错。 沈阳:我认为,ChatGPT在技术上是弱人工智能走向强人工智能的重要节点。从商业上来说,应该会引发一场大洗牌。对善于使用网络的人来说,ChatGPT可以成为非常好的助手,在文案写作、检索等领域,能简化三四成的工作量。 杨君:ChatGPT最具突破性的方面在于逻辑衔接能力,但我认为它还不具备独立推理能力。有用户用三段论跟它对话,它得出了不太符合常识的推论,这是AI还赶不上人脑的一大方面。人脑的强大,就在于归纳和推理能力。有人拿阿尔法狗战胜围棋世界冠军,来证明人脑比不过“AI脑”,然而,目前的智能决策都还仅限于特定场景,算法在特定规则下才能表现出非常强的能力。我认为,能适应和突破变化的规则,是强人工智能的重要发展方向。 吴楠:不少用户发现,ChatGPT在一些常识性的、正常人绝对不会犯错的问题上经常犯错,需要人工干预和修正。而到底什么是常识性问题呢?这个界定其实是很困难的,触碰到了比模型本身更高一层、更加原始的“源问题”。对此的研究和探讨,有助于厘清AI在哪些地方需要人的修正和帮助,划分出人机边界。 季逸超:在搜索场景下,ChatGPT还面临一些挑战。对于事实性的问题,机器通过学习能得出一致的答案,比如“中国的首都在哪里?北京”。但对于观点性的、百家争鸣的问题,如何保证机器学习后,能给我们一个全面公正、没有偏见的结果? 陈雨强:我问了ChatGPT一个问题:如果要做生意,是卖咖啡好还是卖椰子水好?这个问题背后,其实是对商业模式的判断。对ChatGPT而言,如果曾有人在互联网上对比过卖咖啡和卖椰子水,而且分析得有见地,那么ChatGPT就能给出令人满意的回答;但如果先前从未有人写过这类文章,ChatGPT是不能产生相关见解的。 无所不能,但对真实性概不负责? 高跃:ChatGPT生成的内容,面临真实性、准确性以及版权方面的问题。这也给我们带来很多挑战——除了辨别真伪、保护版权,还要能够识别这到底是不是个人的创作,或者能区分出哪部分是AI生成,哪部分是人的创作。 陈雨强:对于一篇专业性或学术性的文章,署名作者是一定要负责的,而恰恰ChatGPT是不能负责的。学术论文的署名作者,既要对论文做出了“实质性贡献”,又要能承担相关的责任,而这两条ChatGPT都不满足,并且现阶段ChatGPT生成的内容完全达不到“文不加点”、无需加工的程度,而是需要人的修改、润色、校对,最终得由人来署名。那么,人的智力参与达到什么标准才能署名?这就牵涉到识别内容究竟是由人还是机器生成的问题。 何俊良:如果问ChatGPT我们自己不熟悉的专业领域的问题,它的回答会看起来非常专业,但实际上可能包含很多错误的知识和误导性观点,而我们难以分辨。 真实性问题会带来信赖危机,而一旦公众不敢信赖一款应用,它也便难于发展。比如自动驾驶技术,就算准确性达到99%,但由于AI的决策不可解释、不可完全控制,很多人就不信赖它,不愿意去使用,这也导致自动驾驶技术一直未能普及。 大语言模型目前最亟待解决的问题之一,就是怎么去判断AI的输出到底是对是错,学界也特别关心。 陈雨强:可信性问题确实很重要。目前ChatGPT热度正劲,但除了日活数据,还有一个关键指标是用户留存数,也就是有多少人在一周、一个月、半年之后还在持续使用这款产品。 信息或知识来源是否可靠,每条引用甚至每句话是否都有出处,推理是否经过验证,生成的文章是否可溯源,都会影响用户留存。新鲜劲过去后,可信性问题直接影响用户还愿不愿意使用这款产品。 技术厮杀激烈,蓝海很快会“染红”?...